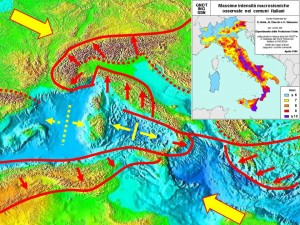

“Perciocchè quanto più i mezzi, co’ quali si imita, son lontani dalle cose da imitarsi, tanto più l’imitazione è meravigliosa”(Galileo Galilei, Opere XI, 341). L’Aquila, ore 3:32 antimeridiane del 6 aprile 2009. Un terremoto di origine naturale (e non militare, come alcuni scrivono su Internet. Un Premio Nobel per la Pace, va assegnato alla Buona Stampa) di magnitudo momento Mw=6.3 (con effetti di risonanza locali ben maggiori) uccide 308 persone, buttando a terra la città capoluogo della Regione Abruzzo, producendo danni morali e materiali incalcolabili. Al di là delle cifre del bilancio finale e dei 4.5 milioni di tonnellate di macerie, il dramma è totale. Eppure nulla in confronto alle altre tragedie di queste ultime settimane. Se ne parlerà all’Egu Spring Meeting 2011 di Vienna che si svolge all’Austria Center dal 3 all’8 aprile. Annus horribilis il 2011. Galileo Galilei insegna che l’umana fantasia è poca cosa rispetto a ciò che riesce a scoprire la Scienza. Quando arriva un terremoto e uno tsunami hai appena il tempo di ricordare il futuro che sarebbe stato. Abbiamo già vissuto in diretta una catastrofe epocale in Giappone. Abbiamo già assistito al coraggioso contegno di un popolo che ha insegnato al mondo intero come sopravvivere alla più spaventosa tragedia naturale della sua storia recente, filmando scene incredibili oggi tutte su Internet, espressioni di una Natura normale e di una politica (anche nucleare delle “raccomandazioni” in centrale!) che non perdona. Mentre la conta dei morti prosegue. Migliaia e migliaia di pagine, relazioni, prolusioni scientifiche sulla catastrofe nipponica dell’11 marzo 2011 (magnitudo 9) e sugli altri “piccoli” terremoti di tutto il mondo, sono al centro dell’annuale Congresso mondiale del European Geosciences Union. Centinaia di giovani ricercatori e scienziati di tutte le nazioni che studiano la Terra e lo Spazio si danno convegno per presentare e discutere i propri lavori. Si è risvegliato anche l’Arco Ellenico alle ore 15:29 del 1° aprile 2011, con la scossa di magnitudo 6 focalizzata a circa 60 km di profondità nei pressi dell’isola di Creta: la regione ha tremato per dieci secondi. Una zona ad altissimo rischio per i terremoti e gli tsunami storici nel Mediterraneo e, dunque, nell’Italia meridionale. Il simposio di Vienna naturalmente prevede una sessione speciale per i recenti disastri sismici di Nuova Zelanda, Giappone e Birmania. Con particolari contributi sul terremoto di L’Aquila (Mw=6.3) di due anni fa (Mw=6.3). C’è sempre una maggior attenzione a sviluppare modelli di previsione probabilistica di breve termine, ma i risultati sono ancora allo stato embrionale. Nella sessione sul terremoto (Mw=9) e sullo tsunami nipponico (onde alte fino a 12 metri) di Tohoku (Sendai) dell’11 marzo scorso (oltre 30mila morti), verranno discussi vari aspetti del fenomeno planetario: le scosse, la tettonica dell’area di sorgente, le onde sismiche registrate e la loro interpretazione scientifica, la magnitudo dei terremoti, le migliaia di repliche altrettanto violente (anche maggiori della scossa principale di L’Aquila), le tecniche di determinazione della magnitudo, la valutazione dei danni causati sia dai terremoti sia dai più violenti tsunami che si sono abbattuti sulla costa giapponese distruggendo tutto fino a 5 Km dal litorale della regione di Tohoku e su tutto l’Oceano Pacifico. Con un occhio di riguardo ai Sistemi globali di Allarme Tsunami, alla rete di boe collocate sugli oceani, perfettamente in rete via satellite, ed alle conseguenze socio-economiche del disastro nipponico che, per la prima volta in assoluto come diretta conseguenza di un fenomeno naturale, contempla pure la catastrofica crisi radiologica nella centrale nucleare di Fukushima, forse peggiore di Chernobyl (http://meetings.copernicus.org/egu2011/home.html). Il terremoto del Giappone era prevedibile? “Le nostre sessioni sui precursori sismici – annuncia il professor Pier Francesco Biagi – hanno circa 80 presentazioni fra orali e poster: saremo presenti con le nostre prime analisi dei dati radio della rete europea. È stata anche organizzata una sessione informale sul recente terremoto del Giappone dell’11 marzo 2011; saremo presenti anche lì perché la nostra rete ha evidenziato un chiaro effetto post-sismico. Posso comunque garantirvi che precursori del terremoto del Giappone sono stati osservati e sono anche molto chiari. Potrò divulgarli dopo il Congresso: siamo sempre sulla breccia”. L’attività sismica mondiale è normale? “Le attività relative agli eventi naturali rientrano in un quadro generale che non muta nel tempo – spiega Antonio Caprai, presidente dell’International Geo-hazard Research Society nell’Istituto di Geoscienze e Georisorse di Pisa – in quanto, come ben si sa, tutto è legato alla struttura geologica del nostro pianeta. Ciò che è avvenuto rientra in una “normale” attività geologica. Quello che invece è cambiata negli anni recenti è sicuramente la pericolosità, un fattore che a parità di rischio è legato alla vulnerabilità delle aree ove vi siano insediamenti urbani. Oggi, contrariamente a ciò che fino ad alcuni decenni or sono avveniva, le città sono estremamente e densamente popolate. Questo non fa altro che aumentarne la pericolosità in quanto lo stesso evento che accade in un piccolo paese non ha le conseguenze dello stesso evento se accade, per esempio, a Tokyo. Ecco, quello che come IGRS ci siamo proposti di portare avanti è la possibile attuazione di un progetto globale che possa verificare in ambito di studio multidisciplinare la possibile previsione di attività sismica. Previsione che a tutt’oggi non è possibile. La strategia di questa previsione è quella di poter installare in aree sensibili pilota, con caratteristiche geologiche diverse, delle strumentazioni che possano rispondere in maniera multidisciplinare a queste domande”.

dello stesso evento se accade, per esempio, a Tokyo. Ecco, quello che come IGRS ci siamo proposti di portare avanti è la possibile attuazione di un progetto globale che possa verificare in ambito di studio multidisciplinare la possibile previsione di attività sismica. Previsione che a tutt’oggi non è possibile. La strategia di questa previsione è quella di poter installare in aree sensibili pilota, con caratteristiche geologiche diverse, delle strumentazioni che possano rispondere in maniera multidisciplinare a queste domande”.

Ma nelle viscere del Gran Sasso d’Italia, un piccolo giallo scientifico attende una rapida soluzione. Perché sarebbe stato “spento”, come annunciano i media, l’esperimento sismologico UnderSeis installato nel Laboratorio Nazionale Infn. Lucchetti all’esperimento per mancanza di soldi, giammai per un’integrazione tecnologica dei sistemi, erano già stati annunciati dal professor Roberto Scarpa nel marzo 2010 in un precedente contributo. UndeSeis è stato ufficialmente sospeso alla fine del 2010. I dati registrati dal 2004 sono tuttora disponibili: ve li riproponiamo a futura memoria di una regione come l’Abruzzo ad altissimo rischio e pericolosità sismica, in piena emergenza planetaria dopo la catastrofe giapponese e gli squilli di tromba dagli abissi del Mediterraneo. Qualcuno capirà finalmente che è il caso di dare un’occhiata più approfondita ai dati forniti da UnderSeis, invece di prestare attenzione a incredibili consulenze burocratiche ufficiali assai discutibili sul piano scientifico. Gli scienziati di UnderSeis avevano concepito un sistema realizzato principalmente per un monitoraggio sismico su scala locale e regionale, adattandolo alla geometria ed alle dimensioni del laboratorio sotterraneo del Gran Sasso. UnderSeis è una rete a piccola apertura (400 x 600 metri) con una distanza media tra i sismometri di circa 90 metri. Era operativo dal maggio 2002.

Il progetto hardware e software di UnderSeis era iniziato nella metà degli anni Novanta. Poi molti aggiornamenti sono stati sviluppati sotto lo sforzo tecnologico degli ingegneri dell’Università di Granada (Spagna), dell’Università di L’Aquila (il team si è poi trasferito all’Università di Salerno sotto la direzione del professor Roberto Scarpa) e dell’Ingv-Osservatorio Vesuviano. I dati di analisi hanno un intervallo temporale compreso tra il 2005 e il 2008. E sono associati con la stessa regione sismogenetica che ha causato il terremoto distruttivo del 6 Aprile a L’Aquila (Mw=6.3; 309 morti). L’analisi, sebbene parziale, di questo massiccio set di dati è inequivocabile. UnderSeis durante i due anni e mezzo precedenti (luglio 2005–dicembre 2008) la devastante sequenza sismica aquilana, ha analizzato e rilevato più di 1600 terremoti, illustrandone la distribuzione temporale del numero di eventi per giorno, stress rilasciato e magnitudo. Per comparare la capacità di UnderSeis con quella della Rete Sismica Nazionale Centralizzata dell’Istituto Nazionale di Geofisica e Vulcanologia, i ricercatori hanno calcolato il numero di eventi rilevati dai due sistemi in funzione della distanza dalla rete. I risultati indicherebbero che le prestazioni di UnderSeis sono migliori o comparabili a quelle della RSNC per distanze epicentrali fino a 30 km. Si è calcolata e illustrata, successivamente, una mappa di densità dei terremoti (numero di eventi per unità di area) per una regione quadrata 50×50 km, centrata sul sito di UnderSeis. La distribuzione della sismicità della rete sarebbe sostanzialmente differente da quella del catalogo Ingv della RSNC. In particolare, gli scienziati avrebbero evidenziato la principale caratteristica della mappa di localizzazione di UnderSeis: un picco di terremoti localizzato molto vicino alla regione ipocentrale della scossa principale (mainshock) del 6 Aprile. “Questo picco, associato con gli epicentri dei due sciami del 2006 – spiegano i ricercatori – è sostanzialmente assente nella mappa di densità della RSNC, dove gli epicentri del 2006 sono spostati 15−20 km a NW”. Quindi UnderSeis ha fornito un potente sistema di monitoraggio per delineare una consistente mappa dell’attività sismica lungo l’Appennino centrale, una delle aree a più alto potenziale sismogenetico d’Italia e, sicuramente, a più elevata pericolosità sismica per la forte antropizzazione. “La posizione sotterranea del sistema – fanno notare i ricercatori del progetto – permette una buona soglia di rilevamento, migliore o comparabile a quella della RSNC, per distanze epicentrali fino a 25−30 km. Le registrazioni multicanale in continuo e il basso livello di rumore, potrebbero aiutarci nella rivelazione della possibile esistenza di altri segnali di origine tettonica, come quelli legati ai terremoti lenti, o episodi di tremore profondo come riscontrato negli anni passati per molte regioni sismicamente attive del mondo”. Le discrepanze osservate tra le localizzazioni della RSNC e quelle di UnderSeis, come si spiegano? Potrebbero essere attribuite ad una combinazione di una scarsa risoluzione della rete ed all’eterogeneità delle velocità che inficiano sia sui travel-time sia sulla geometria del raggio? Una rete di monitoraggio sismico è costituita da una serie di sismografi distribuiti su un’area della superficie della terra, a distanze abbastanza limitate tra loro, in modo che la forma d’onda del segnale possa essere correlata tra i sismometri adiacenti. UnderSeis fino a pochi mesi fa era uno strumento geofisico molto privilegiato, in quanto installato all’interno dei laboratori sotteranei del Gran Sasso (sancta sanctorum della ricerca astro particellare mondiale) che si trovano sotto 1400 metri di roccia in una delle zone più sismiche dell’Appennino centrale italiano. Questo strumento permetteva di monitorare la radiazione sismica con elevata sensibilità, pur essendo composto solo da 19 sismometri di corto periodo a 3 componenti (Lennartz 3D-LITE, 1 Hz) ed un sismometro a larga banda (Guralp GMC-40 T). Come per tutti gli esperimenti scientifici mondiali (compresi quelli nello spazio orbitale), le applicazioni sono molteplici, integrate e multifunzionali. La rete di sismometri di UnderSeis, ad esempio, era sì usata per lo studio della struttura della Terra su scala globale, regionale e locale, e per i processi-sorgente dei terremoti, ma anche per la rilevazione delle esplosioni nucleari e, più recentemente, per l’analisi di segnali complessi associati all’attività vulcanica. Il principale vantaggio di queste reti di sensori sismici consiste nella loro capacità di rivelare piccoli segnali attraverso quello che i ricercatori indicano lo “stacking multicanale della forma d’onda”. La sismicità del Gran Sasso è ben nota in tutto il mondo. Gli scienziati la studiano molto attentamente. Le scosse si avvertono e si registrano ancora oggi (www.emsc-csem.org). La zona del Gran Sasso e dei Monti della Laga è associata con la tettonica distensiva che interessa prevalentemente l’Appennino a partire dalla fine del Pliocene. Eventi catastrofici epocali non si ricordano a memoria di civiltà. Eventi storici recenti includono il terremoto del Fucino Ms=6.8, che causò più di 30mila vittime nel 1915. Inoltre, sciami sismici di moderata grandezza avvengono piuttosto frequentemente, come quelli del 1992, 1994, 1996 e 2006. L’attività sismica più recente è dominata dal devastante terremoto di magnitudo Mw=6.3 del 6 aprile 2009 che ha distrutto la città di L’Aquila, capitale d’Abruzzo, ed i comuni limitrofi, causando 309 vittime. Quest’evento che fa parte di una sequenza sismica iniziata prima del gennaio 2009, avrebbe dovuto insegnare qualcosa. La rilevante sismicità, assieme alle condizioni di basso livello di rumore ed alla risposta di sito associate all’ambiente sotterraneo, fanno dei laboratori del Gran Sasso un sito ideale per osservazioni di carattere sismico ad alta risoluzione. UnderSeis che cosa ha visto prima e dopo il 6 aprile 2009? Il progetto hardware e software di UnderSeis deve essere potenziato e finanziato per l’analisi, lo studio e l’integrazione planetaria dello tsunami di dati finora raccolti.

Il professor Roberto Scarpa, già responsabile dell’esperimento sismologico UnderSeis sotto il Gran Sasso, ricorda le conclusioni del convegno dell’European Geophysical Union tenutosi a Vienna subito dopo la tragedia aquilana. “La mappa illustra la concentrazione spaziale dei terremoti registrati al sistema UnderSeis nel periodo 2006-2008 – fa notare il professor Scarpa – e nella figura viene evidenziata la distribuzione di eventi sismici lungo la zona di frattura attivata il 6 aprile. Il massiccio del Gran Sasso costituisce uno dei sistemi sismogenetici a più elevato potenziale della regione. Da un punto di vista scientifico, l’energia sismica accumulata nella zona di L’Aquila non si è esaurita con l’evento del 6 aprile 2009, ma continua ad accumularsi nella crosta terrestre e nelle faglie adiacenti”. Gli scienziati per faglia del Gran Sasso intendono un sistema costituito da tante faglie espressione in superficie di una sola faglia sismogenetica da considerarsi attiva. L’elaborazione dei dati dovrebbe continuare per la verifica sistematica di eventuali anomalie non solo della sismicità ma delle vibrazioni di fondo (ricerca di segnali coerenti nel tremore), per rilevare debolissimi segnali legati alla fratturazione sismica ed asismica. “Negli ultimi tre anni – rivela il prof. Scarpa – la sismicità si stava addensando intorno alla zona di frattura attivata il 6 aprile. Lo sciame sismico ha certamente aumentato lo stato degli sforzi nelle regioni adiacenti ma non è possibile fare ancora stime rigorose e quantitative dell’aumento di pericolosità in quanto non è noto lo stato degli sforzi in profondità. Andrebbe approfondita la ricerca scientifica su tale settore, cosa che comporta ulteriori sviluppi della ricerca sismologica da realizzare non solo a livello nazionale ma anche internazionale. La comunità sismologica italiana si è adeguata a quella internazionale e compete con pari dignità nella ricerca, ma a mio giudizio occorrerebbe procedere ad una svolta ancora più radicale”. L’elaborazione del sistema UnderSeis non è ancora effettuabile in linea perché non legata ad un programma di monitoraggio di Protezione civile ma solo di ricerca di base. I dati sismologici, tuttavia, sono già utilizzabili ai fini di prevenzione. “Non tutte le ricerche di base – spiega il prof. Scarpa – hanno delle finalità immediatamente applicative e sono convertibili in protocolli da utilizzare a fini pratici. La sperimentazione in questo campo purtroppo può avere dei tempi molto lunghi”. Un evento come il terremoto di L’Aquila può essere conosciuto meglio, unendo il fenomeno naturale e l’evento sociale, facendone un unico oggetto di studio interdisciplinare. Settori tradizionalmente distanti possono dialogare su qualsiasi problema specifico, in primis su cosa provoca il disastro sismico nella lunga storia della regione Abruzzo (preistoria compresa). La prova è contenuta nel nuovo Catalogo sismico nazionale e mediterraneo dell’Ingv. Il professor Roberto Scarpa sa molto bene che è possibile auscultare il cuore della Terra e la roccia viva su cui tutti noi viviamo, un’esile percentuale della crosta terrestre. Il laboratorio del Gran Sasso è un sito davvero speciale per questo genere di ricerche ad alta sensibilità in grado di rivelare le più piccole deformazioni, anche gli effetti mareali prodotti lo scorso marzo 2011 dal massimo avvicinamento della Luna. Il nostro pianeta è vivo, il suo cuore batte di energia nucleare (decadimento radioattivo) ed elettromagnetica. In Italia siamo letteralmente strizzati da placche tettoniche continentali e da sorgenti sismogenetiche potenzialmente pericolose. L’Abruzzo è il “tetto” della dorsale appenninica in grado di liberare istantaneamente energie dell’ordine delle centinaia di megatoni, in terremoti neppure osservati e registrati dalla sismicità storica, capaci di provocare disastri epocali paragonabili ai Big One nipponici e californiani. Alla ricerca dell’onda perfetta, dello stile di rottura della faglia, del modello matematico più raffinato in grado di descrivere il fenomeno sismico e di fare la differenza rispetto alle nostre attuali conoscenze, in prima linea troviamo gli scienziati dell’Istituto nazionale di geofisica e vulcanologia e dell’Osservatorio vesuviano Ingv. Il progetto UnderSeis, gestito dal gruppo del professor Roberto Scarpa dell’Università di Salerno, era un sistema formato da 20 stazioni sismiche ad elevata sensibilità concepito per lo studio dei processi dinamici attivi nella regione appenninica. Una densa rete di sensori e sismografi disposti a raggiera tra le sale e le gallerie sotterranee del Laboratorio Nazionale del Gran Sasso. Dove non si fanno profezie ma scienza galileiana. L’evento sismico di L’Aquila, oltre a produrre una letteratura scientifica senza precedenti al mondo, merita la giusta e costante attenzione di tutti. “Abbiamo le registrazioni giornaliere a tutte le stazioni dell’antenna, nei giorni 5 e 6 aprile 2009 e si evidenziano – spiega il professor Scarpa – la relativa calma il giorno precedente e la scossa principale seguita da numerose repliche. D’altra parte i dati sismologici sono utilizzabili solo ai fini di prevenzione per caratterizzare la sismicità di un territorio e non per la previsione. Questa rimane ad oggi solo un obiettivo di ricerca coronato più da insuccessi che da successi. I media spesso, dopo il verificarsi di queste calamità, riportano casi di previsione, sempre risultati inefficaci dopo attenta verifica scientifica. Basti ricordare il metodo VAN, così pubblicizzato per anni ed anche ritenuto valido da personalità nel campo, che ha mostrato correlazioni inesistenti con i terremoti”. L’esperimento UnderSeis, quindi, aveva già monitorato quattro sciami sismici (agosto 1992, giugno 1994, ottobre 1996 e 13 gennaio 2004) con il più grande tra questi eventi avente magnitudo locale 4.2. “Questi sciami costituiscono gli eventi più intensi avvenuti dopo il 1985 nella stessa regione. UnderSeis era un unico sistema di monitoraggio utile a indagare l’attività sismica dell’Appennino centrale ed in particolare del massiccio del Gran Sasso e dell’intera regione Abruzzo. La posizione all’interno del laboratorio sotterraneo del Gran Sasso, assicurava un soglia di sensibilità molto importante (magnitudo=1.0) con un elevato rapporto segnale-rumore. Le analisi svolte confermano che la risoluzione di UnderSeis permetteva analisi in tempo reale della sismicità di bassa e media intensità. Queste capacità aprono nuovi scenari nella definizione delle strutture sismogenetiche, unitamente a studi dell’inomogeneità della crosta terrestre e dei processi sorgente. La faglia che ha scatenato il terremoto a L’Aquila il 6 aprile 2009 non sarebbe stata dunque quella tra le più pericolose presenti nella zona. Il sistema montuoso del Gran Sasso d’Italia è attraversato da una serie di grandi sorgenti sismogenetiche, alcune note e più superficiali, altre definite “cieche”. In corrispondenza della faglia di Paganica gli studiosi hanno rilevato un affondamento del terreno di 25 cm da un lato con un corrispondente innalzamento del terreno al lato opposto. “La faglia che ha attivato la sequenza sismica del 2009 rientra in un sistema di fratture che predomina nell’Appennino centrale e meridionale, che sono chiamate di tipo diretto o normale, capaci di generare movimenti verticali che producono un preponderante abbassamento del suolo fino a circa un metro. Tali faglie hanno una direzione che segue quella della catena montuosa e possono generare terremoti con estensione spaziale e abbassamenti anche maggiori di quelli riscontrati nell’aprile 2009. Il terremoto del Fucino del 1915 fu caratterizzato da un abbassamento superficiale fino a mezzo metro ed una lunghezza di circa 40 km della faglia responsabile di tale evento. I dati geodetici satellitari ed i rilievi geologici eseguiti dopo il terremoto principale di L’Aquila, indicano come attivata una di queste strutture, nota come faglia di Paganica, per una lunghezza di poco più di 10 km”. L’Abruzzo ha superato la crisi sismica? “Se si intende che il decorso della sismicità in seguito all’evento principale in prossimità della zona di frattura, segue un andamento tipico di decadimento, ciò corrisponde ai dati che abbiamo acquisito finora. Da un punto di vista scientifico ciò però non dimostra che l’energia sismica accumulata nella zona si sia esaurita con questa sequenza. I terremoti lenti riscontrati e gli altri episodi di rilascio asismico dell’energia meccanica rilevati negli impianti che abbiamo gestito sotto i Laboratori del Gran Sasso, sembrano essere eventi rari e con una non semplice corrispondenza con la crisi in atto. Dal punto di vista dell’analisi dei precursori sismici, non abbiamo evidenze di una loro esistenza, pur avendo rilevato che negli ultimi tre anni la sismicità si stava addensando intorno alla zona di frattura attivata lo scorso 6 aprile”. Lo evidenzia la distribuzione delle repliche. “La distribuzione spaziale delle repliche si è mantenuta pressoché costante fin dai primi giorni con attivazione di alcune sequenze secondarie nei Monti della Laga e dei Reatini. Lo sciame sismico ha certamente aumentato lo stato degli sforzi nelle regioni adiacenti ma non è possibile fare ancora stime rigorose e quantitative dell’aumento di pericolosità in quanto non è noto lo stato degli sforzi in profondità”. Convegni, congressi e pubblicazioni scientifiche nazionali e internazionali sono stati e saranno dedicati al terremoto di L’Aquila. “Il rapporto tra le faglie presenti e quelle attive da un punto di vista sismico, rimane ancora argomento di discussione scientifica. Il terremoto di L’Aquila è tra quelli meglio studiati ed oggetto di diversi convegni e pubblicazioni. La previsione statistica a lungo termine di quest’evento, è stata effettuata dalla comunità sismologica nazionale ed oggetto di pubblicazioni scientifiche. Le incertezze su tali modelli sono però tra gli elementi che non ne consentono ancora una pratica utilizzazione. I danni maggiori per questo tipo di terremoti sono purtroppo ancora conseguenze della scarsa attenzione che viene data nel nostro Paese alla cultura della prevenzione”. Nella storia abbiamo una ricorrenza di terremoti simili in queste aree. “La documentazione esistente sui terremoti storici rivela molte analogie con l’attuale sismicità ed ha portato a classificare la regione come tra quelle a rischio. Tutte le previsioni sulla sismicità futura si basano su modelli di tipo probabilistico e su stime della velocità di deformazione delle strutture interessate. In Italia questi studi sono resi ancora più complessi dalla presenza di numerose faglie e dalla loro, fortunatamente per noi, piccola dimensione”. Un sistema di faglie sismogenetiche attraversano l’Appennino abruzzese: la scienza oggi è in grado di calcolare, per ognuna di esse, la probabilità di produrre eventi sismici? “Esiste un sistema composto da almeno tre diramazioni principali che scorrono quasi parallelamente lungo

Il professor Roberto Scarpa, già responsabile dell’esperimento sismologico UnderSeis sotto il Gran Sasso, ricorda le conclusioni del convegno dell’European Geophysical Union tenutosi a Vienna subito dopo la tragedia aquilana. “La mappa illustra la concentrazione spaziale dei terremoti registrati al sistema UnderSeis nel periodo 2006-2008 – fa notare il professor Scarpa – e nella figura viene evidenziata la distribuzione di eventi sismici lungo la zona di frattura attivata il 6 aprile. Il massiccio del Gran Sasso costituisce uno dei sistemi sismogenetici a più elevato potenziale della regione. Da un punto di vista scientifico, l’energia sismica accumulata nella zona di L’Aquila non si è esaurita con l’evento del 6 aprile 2009, ma continua ad accumularsi nella crosta terrestre e nelle faglie adiacenti”. Gli scienziati per faglia del Gran Sasso intendono un sistema costituito da tante faglie espressione in superficie di una sola faglia sismogenetica da considerarsi attiva. L’elaborazione dei dati dovrebbe continuare per la verifica sistematica di eventuali anomalie non solo della sismicità ma delle vibrazioni di fondo (ricerca di segnali coerenti nel tremore), per rilevare debolissimi segnali legati alla fratturazione sismica ed asismica. “Negli ultimi tre anni – rivela il prof. Scarpa – la sismicità si stava addensando intorno alla zona di frattura attivata il 6 aprile. Lo sciame sismico ha certamente aumentato lo stato degli sforzi nelle regioni adiacenti ma non è possibile fare ancora stime rigorose e quantitative dell’aumento di pericolosità in quanto non è noto lo stato degli sforzi in profondità. Andrebbe approfondita la ricerca scientifica su tale settore, cosa che comporta ulteriori sviluppi della ricerca sismologica da realizzare non solo a livello nazionale ma anche internazionale. La comunità sismologica italiana si è adeguata a quella internazionale e compete con pari dignità nella ricerca, ma a mio giudizio occorrerebbe procedere ad una svolta ancora più radicale”. L’elaborazione del sistema UnderSeis non è ancora effettuabile in linea perché non legata ad un programma di monitoraggio di Protezione civile ma solo di ricerca di base. I dati sismologici, tuttavia, sono già utilizzabili ai fini di prevenzione. “Non tutte le ricerche di base – spiega il prof. Scarpa – hanno delle finalità immediatamente applicative e sono convertibili in protocolli da utilizzare a fini pratici. La sperimentazione in questo campo purtroppo può avere dei tempi molto lunghi”. Un evento come il terremoto di L’Aquila può essere conosciuto meglio, unendo il fenomeno naturale e l’evento sociale, facendone un unico oggetto di studio interdisciplinare. Settori tradizionalmente distanti possono dialogare su qualsiasi problema specifico, in primis su cosa provoca il disastro sismico nella lunga storia della regione Abruzzo (preistoria compresa). La prova è contenuta nel nuovo Catalogo sismico nazionale e mediterraneo dell’Ingv. Il professor Roberto Scarpa sa molto bene che è possibile auscultare il cuore della Terra e la roccia viva su cui tutti noi viviamo, un’esile percentuale della crosta terrestre. Il laboratorio del Gran Sasso è un sito davvero speciale per questo genere di ricerche ad alta sensibilità in grado di rivelare le più piccole deformazioni, anche gli effetti mareali prodotti lo scorso marzo 2011 dal massimo avvicinamento della Luna. Il nostro pianeta è vivo, il suo cuore batte di energia nucleare (decadimento radioattivo) ed elettromagnetica. In Italia siamo letteralmente strizzati da placche tettoniche continentali e da sorgenti sismogenetiche potenzialmente pericolose. L’Abruzzo è il “tetto” della dorsale appenninica in grado di liberare istantaneamente energie dell’ordine delle centinaia di megatoni, in terremoti neppure osservati e registrati dalla sismicità storica, capaci di provocare disastri epocali paragonabili ai Big One nipponici e californiani. Alla ricerca dell’onda perfetta, dello stile di rottura della faglia, del modello matematico più raffinato in grado di descrivere il fenomeno sismico e di fare la differenza rispetto alle nostre attuali conoscenze, in prima linea troviamo gli scienziati dell’Istituto nazionale di geofisica e vulcanologia e dell’Osservatorio vesuviano Ingv. Il progetto UnderSeis, gestito dal gruppo del professor Roberto Scarpa dell’Università di Salerno, era un sistema formato da 20 stazioni sismiche ad elevata sensibilità concepito per lo studio dei processi dinamici attivi nella regione appenninica. Una densa rete di sensori e sismografi disposti a raggiera tra le sale e le gallerie sotterranee del Laboratorio Nazionale del Gran Sasso. Dove non si fanno profezie ma scienza galileiana. L’evento sismico di L’Aquila, oltre a produrre una letteratura scientifica senza precedenti al mondo, merita la giusta e costante attenzione di tutti. “Abbiamo le registrazioni giornaliere a tutte le stazioni dell’antenna, nei giorni 5 e 6 aprile 2009 e si evidenziano – spiega il professor Scarpa – la relativa calma il giorno precedente e la scossa principale seguita da numerose repliche. D’altra parte i dati sismologici sono utilizzabili solo ai fini di prevenzione per caratterizzare la sismicità di un territorio e non per la previsione. Questa rimane ad oggi solo un obiettivo di ricerca coronato più da insuccessi che da successi. I media spesso, dopo il verificarsi di queste calamità, riportano casi di previsione, sempre risultati inefficaci dopo attenta verifica scientifica. Basti ricordare il metodo VAN, così pubblicizzato per anni ed anche ritenuto valido da personalità nel campo, che ha mostrato correlazioni inesistenti con i terremoti”. L’esperimento UnderSeis, quindi, aveva già monitorato quattro sciami sismici (agosto 1992, giugno 1994, ottobre 1996 e 13 gennaio 2004) con il più grande tra questi eventi avente magnitudo locale 4.2. “Questi sciami costituiscono gli eventi più intensi avvenuti dopo il 1985 nella stessa regione. UnderSeis era un unico sistema di monitoraggio utile a indagare l’attività sismica dell’Appennino centrale ed in particolare del massiccio del Gran Sasso e dell’intera regione Abruzzo. La posizione all’interno del laboratorio sotterraneo del Gran Sasso, assicurava un soglia di sensibilità molto importante (magnitudo=1.0) con un elevato rapporto segnale-rumore. Le analisi svolte confermano che la risoluzione di UnderSeis permetteva analisi in tempo reale della sismicità di bassa e media intensità. Queste capacità aprono nuovi scenari nella definizione delle strutture sismogenetiche, unitamente a studi dell’inomogeneità della crosta terrestre e dei processi sorgente. La faglia che ha scatenato il terremoto a L’Aquila il 6 aprile 2009 non sarebbe stata dunque quella tra le più pericolose presenti nella zona. Il sistema montuoso del Gran Sasso d’Italia è attraversato da una serie di grandi sorgenti sismogenetiche, alcune note e più superficiali, altre definite “cieche”. In corrispondenza della faglia di Paganica gli studiosi hanno rilevato un affondamento del terreno di 25 cm da un lato con un corrispondente innalzamento del terreno al lato opposto. “La faglia che ha attivato la sequenza sismica del 2009 rientra in un sistema di fratture che predomina nell’Appennino centrale e meridionale, che sono chiamate di tipo diretto o normale, capaci di generare movimenti verticali che producono un preponderante abbassamento del suolo fino a circa un metro. Tali faglie hanno una direzione che segue quella della catena montuosa e possono generare terremoti con estensione spaziale e abbassamenti anche maggiori di quelli riscontrati nell’aprile 2009. Il terremoto del Fucino del 1915 fu caratterizzato da un abbassamento superficiale fino a mezzo metro ed una lunghezza di circa 40 km della faglia responsabile di tale evento. I dati geodetici satellitari ed i rilievi geologici eseguiti dopo il terremoto principale di L’Aquila, indicano come attivata una di queste strutture, nota come faglia di Paganica, per una lunghezza di poco più di 10 km”. L’Abruzzo ha superato la crisi sismica? “Se si intende che il decorso della sismicità in seguito all’evento principale in prossimità della zona di frattura, segue un andamento tipico di decadimento, ciò corrisponde ai dati che abbiamo acquisito finora. Da un punto di vista scientifico ciò però non dimostra che l’energia sismica accumulata nella zona si sia esaurita con questa sequenza. I terremoti lenti riscontrati e gli altri episodi di rilascio asismico dell’energia meccanica rilevati negli impianti che abbiamo gestito sotto i Laboratori del Gran Sasso, sembrano essere eventi rari e con una non semplice corrispondenza con la crisi in atto. Dal punto di vista dell’analisi dei precursori sismici, non abbiamo evidenze di una loro esistenza, pur avendo rilevato che negli ultimi tre anni la sismicità si stava addensando intorno alla zona di frattura attivata lo scorso 6 aprile”. Lo evidenzia la distribuzione delle repliche. “La distribuzione spaziale delle repliche si è mantenuta pressoché costante fin dai primi giorni con attivazione di alcune sequenze secondarie nei Monti della Laga e dei Reatini. Lo sciame sismico ha certamente aumentato lo stato degli sforzi nelle regioni adiacenti ma non è possibile fare ancora stime rigorose e quantitative dell’aumento di pericolosità in quanto non è noto lo stato degli sforzi in profondità”. Convegni, congressi e pubblicazioni scientifiche nazionali e internazionali sono stati e saranno dedicati al terremoto di L’Aquila. “Il rapporto tra le faglie presenti e quelle attive da un punto di vista sismico, rimane ancora argomento di discussione scientifica. Il terremoto di L’Aquila è tra quelli meglio studiati ed oggetto di diversi convegni e pubblicazioni. La previsione statistica a lungo termine di quest’evento, è stata effettuata dalla comunità sismologica nazionale ed oggetto di pubblicazioni scientifiche. Le incertezze su tali modelli sono però tra gli elementi che non ne consentono ancora una pratica utilizzazione. I danni maggiori per questo tipo di terremoti sono purtroppo ancora conseguenze della scarsa attenzione che viene data nel nostro Paese alla cultura della prevenzione”. Nella storia abbiamo una ricorrenza di terremoti simili in queste aree. “La documentazione esistente sui terremoti storici rivela molte analogie con l’attuale sismicità ed ha portato a classificare la regione come tra quelle a rischio. Tutte le previsioni sulla sismicità futura si basano su modelli di tipo probabilistico e su stime della velocità di deformazione delle strutture interessate. In Italia questi studi sono resi ancora più complessi dalla presenza di numerose faglie e dalla loro, fortunatamente per noi, piccola dimensione”. Un sistema di faglie sismogenetiche attraversano l’Appennino abruzzese: la scienza oggi è in grado di calcolare, per ognuna di esse, la probabilità di produrre eventi sismici? “Esiste un sistema composto da almeno tre diramazioni principali che scorrono quasi parallelamente lungo l’Appennino abruzzese. La loro attività non è tale da permetterci di calcolare precisamente ed individualmente la probabilità di accadimento di terremoti per le varie classi di magnitudo. Per quanto riguarda la correlazione con il gas radon, la situazione è ancora più complessa e non sono il solo a ritenere che gli studi finora fatti, non solo nella regione, ma in tutto il mondo, non diano dei risultati univoci e significativi”. Un motivo in più per la società civile e la comunità scientifica italiana, per accrescere la cultura sui fenomeni fisici del terremoto, fin dalla scuola dell’infanzia. “Nel nostro Paese dovremmo innanzitutto trovare tutte le risorse per accrescere la cultura in generale e non tagliare i fondi destinati alla ricerca scientifica che sono ridotti a ben poca cosa relativamente ad altri Paesi. Per la cultura sul terremoto, dal sisma del 1980 sono stati fatti passi da gigante con la creazione dell’attuale Dipartimento della Protezione Civile. Dovremo ancora continuare e non rallentare tale andamento a tutti i livelli dell’istruzione. Constato purtroppo che molti testi scolastici riportano sul fenomeno terremoto delle nozioni completamente erronee. Ad esempio, leggo ancora dell’esistenza di terremoti di crollo e spesso riscontro ancora confusione tra causa ed effetti dei terremoti”. Grazie agli studi dei nostri scienziati, sarà forse possibile un giorno predisporre tecnologie in grado di “combattere e vincere” i terremoti in tempi e luoghi utili e certi, rivoluzionando così la cultura della “prevenzione” del rischio sismico in Italia, come hanno già capito in California e in Giappone dove, a una settimana dal catastrofico terremoto dell’11 marzo 2011, sono riusciti a ricostruzione un tratto autostradale severamente danneggiato. “L’Ingv e la comunità universitaria hanno fatto dei grossi passi in avanti in materia, specie se guardiamo alla situazione nel campo rispetto a qualche decina di anni or sono. La comunità sismologica italiana si è adeguata a quella internazionale e compete con pari dignità nella ricerca, ma a mio giudizio occorrerebbe procedere ad una svolta ancora più radicale cosa che è limitata dall’attuale congiuntura economica. Uno sforzo più radicale richiede maggiori investimenti nella ricerca scientifica e nell’Università”. L’antenna sismica sotterranea del Gran Sasso (UnderSeis) e l’interferometro laser GIGS, in grado di monitorare la radiazione sismica con elevata sensibilità, possono ancora oggi offrire un grande contributo a queste ricerche. “I dati dell’antenna sismica sotterranea di cui ho curato lo sviluppo, stanno fornendo dei contributi scientifici di estrema rilevanza per la comprensione dei processi sismogenetici, unitamente all’esperimento GIGS, il cui responsabile è il professor Crescentini: siamo, cioè, in grado di studiare in questa parte dell’Appennino il rilascio dell’energia meccanica per i fenomeni sismici che producono vibrazioni a frequenze avvertibili dall’uomo, e per i fenomeni asismici, cioè a bassissime frequenze”.

l’Appennino abruzzese. La loro attività non è tale da permetterci di calcolare precisamente ed individualmente la probabilità di accadimento di terremoti per le varie classi di magnitudo. Per quanto riguarda la correlazione con il gas radon, la situazione è ancora più complessa e non sono il solo a ritenere che gli studi finora fatti, non solo nella regione, ma in tutto il mondo, non diano dei risultati univoci e significativi”. Un motivo in più per la società civile e la comunità scientifica italiana, per accrescere la cultura sui fenomeni fisici del terremoto, fin dalla scuola dell’infanzia. “Nel nostro Paese dovremmo innanzitutto trovare tutte le risorse per accrescere la cultura in generale e non tagliare i fondi destinati alla ricerca scientifica che sono ridotti a ben poca cosa relativamente ad altri Paesi. Per la cultura sul terremoto, dal sisma del 1980 sono stati fatti passi da gigante con la creazione dell’attuale Dipartimento della Protezione Civile. Dovremo ancora continuare e non rallentare tale andamento a tutti i livelli dell’istruzione. Constato purtroppo che molti testi scolastici riportano sul fenomeno terremoto delle nozioni completamente erronee. Ad esempio, leggo ancora dell’esistenza di terremoti di crollo e spesso riscontro ancora confusione tra causa ed effetti dei terremoti”. Grazie agli studi dei nostri scienziati, sarà forse possibile un giorno predisporre tecnologie in grado di “combattere e vincere” i terremoti in tempi e luoghi utili e certi, rivoluzionando così la cultura della “prevenzione” del rischio sismico in Italia, come hanno già capito in California e in Giappone dove, a una settimana dal catastrofico terremoto dell’11 marzo 2011, sono riusciti a ricostruzione un tratto autostradale severamente danneggiato. “L’Ingv e la comunità universitaria hanno fatto dei grossi passi in avanti in materia, specie se guardiamo alla situazione nel campo rispetto a qualche decina di anni or sono. La comunità sismologica italiana si è adeguata a quella internazionale e compete con pari dignità nella ricerca, ma a mio giudizio occorrerebbe procedere ad una svolta ancora più radicale cosa che è limitata dall’attuale congiuntura economica. Uno sforzo più radicale richiede maggiori investimenti nella ricerca scientifica e nell’Università”. L’antenna sismica sotterranea del Gran Sasso (UnderSeis) e l’interferometro laser GIGS, in grado di monitorare la radiazione sismica con elevata sensibilità, possono ancora oggi offrire un grande contributo a queste ricerche. “I dati dell’antenna sismica sotterranea di cui ho curato lo sviluppo, stanno fornendo dei contributi scientifici di estrema rilevanza per la comprensione dei processi sismogenetici, unitamente all’esperimento GIGS, il cui responsabile è il professor Crescentini: siamo, cioè, in grado di studiare in questa parte dell’Appennino il rilascio dell’energia meccanica per i fenomeni sismici che producono vibrazioni a frequenze avvertibili dall’uomo, e per i fenomeni asismici, cioè a bassissime frequenze”.

L’Abruzzo deve far sua l’esperienza scientifica, didattica e culturale dei californiani e dei giapponesi che sanno convivere con il terremoto. “Come esperti della materia ci auguriamo sempre che aumenti il grado di sensibilizzazione su queste problematiche che oggi riguardano l’Abruzzo, ieri il Friuli e la Campania e Basilicata ed un domani molte altre regioni italiane che già sono individuate dalle numerose cartografie sismiche a disposizione e visibili anche in Internet”.

Le relazioni dettagliate tra le deformazioni che caricano la catena sul margine adriatico e quelle dei “graben” appenninici che la scaricano, sono state studiate dai geologi, dai sismotettonici e dai sismologi italiani. Comprese le sorgenti sismogenetiche più vicine. “La città e la provincia di Teramo possono risentire principalmente degli effetti di terremoti del massiccio del Gran Sasso, che costituisce il sistema sismogenetico a più elevato potenziale della regione. Le relazioni dettagliate tra il sistema adriatico e quello appenninico sono oggetto di studio da vari anni dal gruppo dell’Università di Siena, unitamente al mio gruppo e dal gruppo dell’Università di Bologna, con risultati che mostrano quantitativamente come varia il livello di pericolosità anche in funzione del tempo”. Nell’oceano Pacifico, solo la scossa principale di magnitudo 9 del Giappone ha fatto tremare l’intero pianeta come una campagna per diverse ore. Era 30mila volte più potente, in termini di energia rilasciata, del sisma di L’Aquila (un megatone) delle 3:32 del 6 aprile 2009, pari cioè a decine di migliaia di megatoni “sparati” in un pezzo di crosta terrestre lungo come la distanza Milano-Roma e largo come la Roma-Pescara. Siamo già al quarto Annus horribilis di catastrofi sismiche nei primi due decenni del 21° Secolo. Il trend crescente di catastrofi sismiche nel mondo può destabilizzare le faglie italiane?

Le relazioni dettagliate tra le deformazioni che caricano la catena sul margine adriatico e quelle dei “graben” appenninici che la scaricano, sono state studiate dai geologi, dai sismotettonici e dai sismologi italiani. Comprese le sorgenti sismogenetiche più vicine. “La città e la provincia di Teramo possono risentire principalmente degli effetti di terremoti del massiccio del Gran Sasso, che costituisce il sistema sismogenetico a più elevato potenziale della regione. Le relazioni dettagliate tra il sistema adriatico e quello appenninico sono oggetto di studio da vari anni dal gruppo dell’Università di Siena, unitamente al mio gruppo e dal gruppo dell’Università di Bologna, con risultati che mostrano quantitativamente come varia il livello di pericolosità anche in funzione del tempo”. Nell’oceano Pacifico, solo la scossa principale di magnitudo 9 del Giappone ha fatto tremare l’intero pianeta come una campagna per diverse ore. Era 30mila volte più potente, in termini di energia rilasciata, del sisma di L’Aquila (un megatone) delle 3:32 del 6 aprile 2009, pari cioè a decine di migliaia di megatoni “sparati” in un pezzo di crosta terrestre lungo come la distanza Milano-Roma e largo come la Roma-Pescara. Siamo già al quarto Annus horribilis di catastrofi sismiche nei primi due decenni del 21° Secolo. Il trend crescente di catastrofi sismiche nel mondo può destabilizzare le faglie italiane?

La prima vittima di un terremoto è la verità scientifica sacrificata sull’altare della disinformazione ad uso politico. Ecco il “peccato originale”. Le prime vittime nelle catastrofi naturali come sempre sono i ricercatori di un Paese che vanta di aver dato i natali al padre della fisica subnucleare e della prima centrale a fissione del Sistema Solare (Enrico Fermi). Un’Italia che ancora oggi fa fatica a ricordare ai giovani di averlo scacciato dal suo Paese, insieme a tanti altri cervelli del Romano Impero. Si dimentica troppo facilmente che fummo privati negli Anni Trenta del 20° Secolo del primato assoluto mondiale nella produzione di energia nucleare. E vi pare poco! Cosa c’entra con il terremoto di L’Aquila? Tutti i drammi della storia del nostro Bel Paese ci ricordano che ogni anno ricercatori (non di funghi!) e scienziati italiani sono costretti a fare anche i burocrati, alla quasi disperata ricerca di fondi in tempo di pace e di guerra, sottraendo così ore preziose alla ricerca. Per fare cosa? Per poter applicare il metodo galileiano della riproducibilità degli esperimenti scientifici con sacrifici personali e familiari indescrivibili per qualunque fiction tv. Il fatto è che il caos della politica autoreferenziale aborre la verità e la giustizia. Ecco perché la Scienza non è la politica. Che non ama la Scienza. E non può essere altrimenti. Perché se la Politica applicasse il metodo galileiano, avremmo già risolto le cento e più emergenze planetarie, fame e guerre comprese. Potremmo fare a meno dell’industria della solidarietà e magari sostituirla con quella del volo interstellare per la produzione di vere astronavi, superando le stesse perplessità della Nasa. Avremmo già risolto ed applicato le leggi esistenti sulla prevenzione del rischio sismico in Italia, senza alcun bisogno di inventare macchine che prevedono i terremoti magari per convincere la gente a uscire di casa per beccarsi un coppo in testa! Ma non è così che vanno le cose. Compito dei giornalisti è porre le domande alle persone giuste, non a chiunque, stimolando i Politici veri e capaci ad attuare politiche serie, credibili e utili ai cittadini. In una Democrazia parlamentare come quella Italiana, in uno Stato di diritto da 150 anni, che ancora oggi vanta nel proprio Ordinamento repubblicano norme “fasciste” in grado di mandare in galera i giornalisti, è tutto più difficile se non praticamente impossibile. Figurarsi praticare la nobile e democratica funzione di “cani da guardia” della Democrazia e della Libertà. I giornalisti oggi sulla Terra corrono brutti rischi e pericolosi tiri mancini da parte di chiunque al Potere voglia sbarazzarsi di loro, quindi della verità, della giustizia e della libertà di stampa, di comunicazione e di informazione anche scientifica. Oggi in Italia, soprattutto sul territorio, sentiamo forte questo pericolo nonostante Internet. Basta spegnere la corrente e il personal computer. E si torna indietro di 60 anni. In verità i giornalisti, compresi quelli scientifici, oggi non sono liberi. Fabrice Bellard, un informatico francese, è riuscito a calcolare con un software artigianale e un ordinario elaboratore elettronico 2,7 trilioni di decimali del famoso “Pi” greco (π = 3,14…) superando di cento miliardi di cifre i risultati di un computer giapponese più costoso. Che interesse può avere oggi questo tipo di ricerca? Che senso ha una fatica del genere apparentemente inutile? Non è rimasto proprio nulla da cercare, da sapere, da capire? Il confine tra verità scientifica, plausibilità e fantascienza, è sempre più labile. Siamo sulla Terra e non sul pianeta Pandora del kolossal di James Cameron “Avatar”. Faccio degli esempi. Lo scorso anno è stato scoperto il 430° esopianeta (spiace per gli astrologi che non lo hanno previsto!) combinando le osservazioni del telescopio spaziale francese CoRoT e del sistema ottico Harps dell’Osservatorio astronomico australe dell’Eso in Cile. Gli astronomi hanno scoperto il primo pianeta extrasolare “normale” della Galassia. Il primo gigante gassoso di taglia gioviana che può essere studiato in grande dettaglio, visto che orbita regolarmente, esattamente come il nostro Mercurio, attorno alla propria stella. Corot-9b, così è stato designato il pianeta, transita regolarmente attorno al proprio luminare di classe spettrale G3 (“simile” al nostro Sole) in appena 95 giorni. E’ distante 1500 anni-luce dalla Terra nella costellazione del Serpente. Tuttavia dire che è stato scoperto “un nuovo mondo” è del tutto improprio. Anche se nulla esclude che in quel lontano sistema solare, chissà, vi possano essere altri pianeti di taglia terrestre, come Pandora, magari in orbita attorno a giganti gassosi come Polifemo. Saranno gli altri telescopi terrestri, e spaziali, a confermarlo. Così lavora la scienza che non ha fretta. Alcuni giorni dopo alcuni ricercatori dell’Istituto Nazionale di Geofisica e Vulcanologia pubblicano un articolo semplice e comprensibile sulle emissioni di gas radon dalle rocce sotto sforzo. Una ricerca firmata da studiosi dell’Istituto Nazionale di Geofisica e Vulcanologia e dell’Università Roma Tre (Paola Tuccimei, Silvio Mollo, Sergio Vinciguerra, Mauro Castelluccio, Michele Soligo) avrebbe permesso di isolare i meccanismi fondamentali che determinano la diminuzione e l’aumento del rilascio del gas radon prima di un terremoto. Il lavoro pubblicato sul Geophysical Reaserch Letters è stato finanziato dal progetto Trigs (www.trigs.eu), sotto il sesto programma quadro della Commissione Europea e del “New and Emerging Science and Technology Pathfinder”. Il lavoro spiega che la diminuzione di gas radon può essere il precursore di processi di fratturazione e quindi anomalie negative di rilascio di gas dovrebbero essere considerate indicatrici di imminenti rotture. Il risultato principale è che l’emissione di radon dipende dalla porosità delle rocce: a seconda dei casi questa può aumentare o diminuire ma sarebbe impossibile oggi utilizzare l’emissione di radon per prevedere un terremoto. Qual è stato il comportamento dei media? “Il comportamento dei media, almeno di quelli che ho letto – fa notare il prof. Warner Marzocchi – è stato molto superficiale e ha trasmesso un messaggio sbagliato. Riportare che l’Ingv conferma altre ipotesi, è assurdo. L’articolo riportato nel comunicato stampa Ingv espone una plausibilità del radon come precursore sismico. Questa non è una novità in quanto già dagli anni ‘60 si era trovata questa plausibilità ed è la ragione per la quale molti iniziarono a studiare il radon come precursore già 40-50 anni fa. La novità dell’articolo Ingv è l’utilizzo di un modello per certi versi più sofisticato. Ma la plausibilità è solo un primo passo che non implica un utilizzo immediato”. Cioè? “Negli ultimi decenni si è trovata una certa plausibilità come precursore per moltissimi fenomeni, come le emissioni acustiche, quelle elettromagnetiche, diversi tipi di attività sismica e di anomalie delle onde sismiche ed altro ancora. Purtroppo nessuno di questi precursori ha mai funzionato nel mondo reale. Si spera che in futuro da questi studi di plausibilità possa emergere un’informazione utilizzabile in realtà per prevedere i terremoti, ma per ora siamo lontanissimi”. Quindi? “Per cui dire che tali ricerche Ingv hanno avvalorato il lavoro di qualcun altro, è fuorviante e sbagliato. L’Ingv così come altri Istituti e Università, ha sempre studiato fenomeni precursori (radon incluso). Per cui nessuna novità anche in questo settore. Il problema resta: il terremoto di L’Aquila non era prevedibile prima del 6 aprile 2009 e non lo è nemmeno ora. Con il radon o altri precursori”. Molti giornali avrebbero quindi scritto esattamente il contrario sia attribuendo all’Ingv verifiche di altre ricerche in corso sia sostenendo che i terremoti oggi si possono prevedere. Non è assolutamente deontologico in quanto la scienza ufficiale (tutti hanno già dimenticato il Report sul terremoto aquilano, redatto a L’Aquila il 2 ottobre 2009, nel famoso G10 dei geoscienziati) sostiene che oggi non è assolutamente possibile prevedere con esattezza i terremoti, come abbiamo dimostrato in tutte le nostre interviste realizzate in questi ultimi 25 mesi. E questo in segno di rispetto per tutte le vittime del terremoto in ogni tempo. Della tanta confusione che è stata generata su tali problemi, “specie dopo il verificarsi di catastrofi che tutti hanno sempre predetto a posteriori”, è convinto Roberto Scarpa, professore ordinario di Fisica terrestre e direttore del Centro interdipartimentale di scienze ambientali dell’Università di Salerno, con all’attivo 160 pubblicazioni scientifiche e quattro libri. “Il caso di L’Aquila purtroppo non è isolato e potrei citare innumerevoli del genere avvenuti in Italia e in altre parti del mondo su tali problematiche. Gli eventi sismici – spiega il prof. Roberto Scarpa – sono dei fenomeni naturali di tipo meccanico e lo studio del loro meccanismo e degli eventuali precursori deve essere fatto, secondo la comunità sismologica, principalmente con strumenti a elevata sensibilità in grado di captare le più piccole vibrazioni del suolo e le deformazioni (cioè i processi che causano le fratture)”. Che cosa può dirci con esattezza? “Io ho insegnato Sismologia presso l’Università de L’Aquila nel periodo 1986-2001, cercando di formare non solo gli studenti universitari, ma anche di informare la popolazione, mediante l’organizzazione di conferenze divulgative, sul problema della sismicità del territorio abruzzese, che rimane una delle regioni simicamente più attive d’Italia. Da giovane, come vincitore di un concorso universitario nel settore della Fisica della Terra, mi sono trasferito da Napoli a L’Aquila proprio per studiare i terremoti. All’epoca ero rappresentante dell’Italia, nell’ambito della Commissione Sismologica Europea, per le ricerche nel campo della previsione, ed ho lavorato in questa direzione proprio per cercare nuovi sbocchi nell’ambito di un settore molto controverso, sapendo che questi studi erano coronati, in tutto il mondo, più da insuccessi che da risultati incoraggianti”. Parliamo delle sue ricerche al Laboratorio Nazionale del Gran Sasso dell’Infn, sotto la montagna: ha scoperto qualcosa prima del terremoto del 6 aprile 2009? “In tale ambito, il progetto Underseis, da me coordinato, ha avuto lo scopo di rilevare segnali sismici, inclusi episodi di scorrimento asismico, che non sono avvenuti in occasione dell’evento del 6 Aprile 2009. Gli unici eventi che abbiamo registrato nella regione, non solo pochi mesi prima, ma dal 2005, erano una serie di sciami sismici, che sono avvenuti nella zona di frattura a Nord della faglia attivata nel 2009. D’altro canto altri sciami sismici sono avvenuti ripetutamente a nord di questa regione nel 1992, 1994 e 1996 e sono stati oggetto di studio e di pubblicazioni scientifiche sul Journal of Seismology da parte del mio gruppo di ricerca. Nella regione ha operato fin dal 1986 una delle reti sismiche più avanzate in Italia per le prestazioni tecnologiche”. Dunque? “Il progetto Underseis che utilizza strumentazione con livelli di sensibilità altissime, ha conseguito risultati di grande interesse internazionale”. Invece, c’è un forte interesse in Italia su altri fenomeni, quali il radon e le emissioni elettromagnetiche: che ne pensa? “Che sono effetti indiretti del processo sismico, ma il loro grado di affidabilità è in pratica nullo”. Cioè? “Il radon è stato considerato erroneamente come uno dei primi segnali precursori in relazione al terremoto di Tashkent (M=5.3), avvenuto in Russia nel 1966. In seguito, in varie regioni del mondo sono stati riportati, sempre dopo i terremoti, alcuni eventi anomali di emissione del radon, come a Kobe, nel 1995 (M=7.2) che è stato il secondo terremoto recente più distruttivo del Giappone, anche perché avvenuto nei pressi di una città. Le anomalie riportate nella letteratura scientifica, relativi ai segnali radon avvenuti prima di alcuni terremoti sono appena di alcune decine, rispetto alle decine di migliaia di terremoti monitorati di pari magnitudo. Nel mondo sono registrati circa 800 terremoti all’anno di magnitudo maggiore di 5. Di conseguenza è più affidabile il lancio di una monetina, per prevedere i terremoti, che pensare di investire nella previsione con la tecnica del radon”. Che dire dell’esperienza giapponese? “In Giappone esiste un nuovo programma ufficiale di predizione dei terremoti, nella regione del Tokai, ove è atteso da 30 anni un terremoto di magnitudo 8.4. Il sistema di allarme e di previsione a breve termine (da qualche ora ad alcuni giorni prima dell’evento sismico) si basa su 31 dilatometri da pozzo Sacks-Evertson, collocati a 200 metri di profondità tra il 1975 e il 1980, e non certamente su previsioni basate sulla presenza di radon o di emissioni di origine elettromagnetiche. Sui sistemi dilatometrici da pozzo, lo scrivente sta lavorando con il gruppo di ricerca coordinato dal dott. Sacks della Carnegie Institution di Washington D.C. (USA) in un progetto d’installazione in alcune regioni italiane sismicamente attive; i risultati finora ottenuti sono stati incoraggianti ed oggetto di pubblicazioni scientifiche su riviste internazionali”. E’ possibile salvare i vostri esperimenti sotto il Gran Sasso? “Auspico quindi una maggiore attenzione verso il progetto Underseis per lo studio dei terremoti abruzzesi, base di partenza per sviluppare maggiormente il campo di ricerca nel settore dei segnali precursori debolissimi e non rilevabili con il sistema attuale di monitoraggio regionale e nazionale”. A cosa serve la ricerca, perché finanziarla, cosa fanno i ricercatori, che relazione c’è tra ricerca ed insegnamento, come riformare il sistema della ricerca e dell’università, a quali modelli ispirarsi? “Ricercatori non crescono sugli alberi” è il titolo del libro scritto a quattro mani da Francesco Sylos Labini e Stefano Zapperi sulla ricerca e l’università in Italia. E’ stato pubblicato da Laterza nel gennaio 2010. Due cervelli non in fuga, denunciano la drammatica situazione italiana e cosa fare per uscire dalle secche della crisi. Perché su una cosa non c’è dubbio: se ben gestito, il finanziamento alla ricerca non è un costo ma l’investimento più lungimirante che si possa fare per il futuro del Paese e delle nuove generazioni. “Da più parti – fa notare il prof. Pier Francesco Biagi dell’Università di Bari – si sente dire, e io sono fra questi, che l’intensità della sismicità nel mondo è aumentata. Invece gli esperti di sismologia continuano a sostenere che questo non è vero: ogni anno – dicono – avvengono parecchi terremoti di M=8 nel mondo; la situazione attuale è nella norma; c’è solo la circostanza che alcuni eventi forti si verificano vicino a centri densamente abitati. Questo affermano con sicurezza. Ora, io non mi reputo un sismologo ma un andamento (trend) lo so individuare e capire. Stanco di questo andazzo sono andato nel sito dell’Usgs (ente americano principe in fatto di sismicità mondiale) e mi sono scaricato la tabella della massima magnitudo registrata ogni anno nel mondo a partire dal 1990 ad oggi”. Cos’ha scoperto? “Ho fatto il grafico e ho ricavato il miglior fit lineare dei dati. Bene, il negare che ci sia un aumento dell’intensità della sismicità nel mondo è negare l’evidenza! Allora due sono le possibilità: o gli esperti di sismologia non sanno capire un andamento elementare (e allora è meglio che tornino a scuola) o sono in malafede e dicono il falso (forse per non far preoccupare la gente). Io penso che la gente debba essere informata del vero e non trattata come una manica di ignoranti a cui dire quello che si vuole, anche se contrario all’evidenza. Alcuni miei amici, gente comune non esperta in terremoti, mi dicono spesso che le cose non stiano come dicono gli esperti”. Cioè? “Cioè che è tutto nella norma; mi sembra invece che l’intensità della sismicità sia aumentata”. Cosa sta succedendo nel mondo? “Io da fisico rispondo che hanno ragione e quello che sta succedendo è che siamo in presenza di una fase di massimo; ma cose del genere si sono già verificate nelle ere passate”. Esiste una correlazione tra la sismicità dei Balcani e quella Italiana? “Molti anni fa ho dato una tesi di laurea su questo argomento e il risultato ha dimostrato statisticamente l’esistenza di botta e risposta”. Allora, i terremoti stanno aumentando? “I miei calcoli sono in pratica un’evidente dimostrazione che l’intensità dell’attività sismica mondiale è aumentata negli ultimi anni. In genere la sismicità mondiale è caratterizzata da un andamento ciclico con periodi di massima intensità e periodi di minore intensità; siamo in un periodo di massima. Tutto qui. Nelle ere passate e ancor più vicino nei secoli passati è già successo. A occhio direi che anche la sismicità dell’area mediterranea è in sintonia con l’andamento di quella mondiale. Adesso si fa un gran parlare di radon precursore. Vorrei solo far presente che in Italia (con spirito pioneristico) il mio gruppo di ricerca lavorava e otteneva risultati in questo campo circa trent’anni fa! Alcuni risultati sono stati pubblicati su riviste di prestigio, anche sul GRL. Solo le difficoltà nel reperire finanziamenti e personale ci ha costretto ad interrompere questo filone di ricerca. Ma adesso sono tutti bravi”.

possibile prevedere con esattezza i terremoti, come abbiamo dimostrato in tutte le nostre interviste realizzate in questi ultimi 25 mesi. E questo in segno di rispetto per tutte le vittime del terremoto in ogni tempo. Della tanta confusione che è stata generata su tali problemi, “specie dopo il verificarsi di catastrofi che tutti hanno sempre predetto a posteriori”, è convinto Roberto Scarpa, professore ordinario di Fisica terrestre e direttore del Centro interdipartimentale di scienze ambientali dell’Università di Salerno, con all’attivo 160 pubblicazioni scientifiche e quattro libri. “Il caso di L’Aquila purtroppo non è isolato e potrei citare innumerevoli del genere avvenuti in Italia e in altre parti del mondo su tali problematiche. Gli eventi sismici – spiega il prof. Roberto Scarpa – sono dei fenomeni naturali di tipo meccanico e lo studio del loro meccanismo e degli eventuali precursori deve essere fatto, secondo la comunità sismologica, principalmente con strumenti a elevata sensibilità in grado di captare le più piccole vibrazioni del suolo e le deformazioni (cioè i processi che causano le fratture)”. Che cosa può dirci con esattezza? “Io ho insegnato Sismologia presso l’Università de L’Aquila nel periodo 1986-2001, cercando di formare non solo gli studenti universitari, ma anche di informare la popolazione, mediante l’organizzazione di conferenze divulgative, sul problema della sismicità del territorio abruzzese, che rimane una delle regioni simicamente più attive d’Italia. Da giovane, come vincitore di un concorso universitario nel settore della Fisica della Terra, mi sono trasferito da Napoli a L’Aquila proprio per studiare i terremoti. All’epoca ero rappresentante dell’Italia, nell’ambito della Commissione Sismologica Europea, per le ricerche nel campo della previsione, ed ho lavorato in questa direzione proprio per cercare nuovi sbocchi nell’ambito di un settore molto controverso, sapendo che questi studi erano coronati, in tutto il mondo, più da insuccessi che da risultati incoraggianti”. Parliamo delle sue ricerche al Laboratorio Nazionale del Gran Sasso dell’Infn, sotto la montagna: ha scoperto qualcosa prima del terremoto del 6 aprile 2009? “In tale ambito, il progetto Underseis, da me coordinato, ha avuto lo scopo di rilevare segnali sismici, inclusi episodi di scorrimento asismico, che non sono avvenuti in occasione dell’evento del 6 Aprile 2009. Gli unici eventi che abbiamo registrato nella regione, non solo pochi mesi prima, ma dal 2005, erano una serie di sciami sismici, che sono avvenuti nella zona di frattura a Nord della faglia attivata nel 2009. D’altro canto altri sciami sismici sono avvenuti ripetutamente a nord di questa regione nel 1992, 1994 e 1996 e sono stati oggetto di studio e di pubblicazioni scientifiche sul Journal of Seismology da parte del mio gruppo di ricerca. Nella regione ha operato fin dal 1986 una delle reti sismiche più avanzate in Italia per le prestazioni tecnologiche”. Dunque? “Il progetto Underseis che utilizza strumentazione con livelli di sensibilità altissime, ha conseguito risultati di grande interesse internazionale”. Invece, c’è un forte interesse in Italia su altri fenomeni, quali il radon e le emissioni elettromagnetiche: che ne pensa? “Che sono effetti indiretti del processo sismico, ma il loro grado di affidabilità è in pratica nullo”. Cioè? “Il radon è stato considerato erroneamente come uno dei primi segnali precursori in relazione al terremoto di Tashkent (M=5.3), avvenuto in Russia nel 1966. In seguito, in varie regioni del mondo sono stati riportati, sempre dopo i terremoti, alcuni eventi anomali di emissione del radon, come a Kobe, nel 1995 (M=7.2) che è stato il secondo terremoto recente più distruttivo del Giappone, anche perché avvenuto nei pressi di una città. Le anomalie riportate nella letteratura scientifica, relativi ai segnali radon avvenuti prima di alcuni terremoti sono appena di alcune decine, rispetto alle decine di migliaia di terremoti monitorati di pari magnitudo. Nel mondo sono registrati circa 800 terremoti all’anno di magnitudo maggiore di 5. Di conseguenza è più affidabile il lancio di una monetina, per prevedere i terremoti, che pensare di investire nella previsione con la tecnica del radon”. Che dire dell’esperienza giapponese? “In Giappone esiste un nuovo programma ufficiale di predizione dei terremoti, nella regione del Tokai, ove è atteso da 30 anni un terremoto di magnitudo 8.4. Il sistema di allarme e di previsione a breve termine (da qualche ora ad alcuni giorni prima dell’evento sismico) si basa su 31 dilatometri da pozzo Sacks-Evertson, collocati a 200 metri di profondità tra il 1975 e il 1980, e non certamente su previsioni basate sulla presenza di radon o di emissioni di origine elettromagnetiche. Sui sistemi dilatometrici da pozzo, lo scrivente sta lavorando con il gruppo di ricerca coordinato dal dott. Sacks della Carnegie Institution di Washington D.C. (USA) in un progetto d’installazione in alcune regioni italiane sismicamente attive; i risultati finora ottenuti sono stati incoraggianti ed oggetto di pubblicazioni scientifiche su riviste internazionali”. E’ possibile salvare i vostri esperimenti sotto il Gran Sasso? “Auspico quindi una maggiore attenzione verso il progetto Underseis per lo studio dei terremoti abruzzesi, base di partenza per sviluppare maggiormente il campo di ricerca nel settore dei segnali precursori debolissimi e non rilevabili con il sistema attuale di monitoraggio regionale e nazionale”. A cosa serve la ricerca, perché finanziarla, cosa fanno i ricercatori, che relazione c’è tra ricerca ed insegnamento, come riformare il sistema della ricerca e dell’università, a quali modelli ispirarsi? “Ricercatori non crescono sugli alberi” è il titolo del libro scritto a quattro mani da Francesco Sylos Labini e Stefano Zapperi sulla ricerca e l’università in Italia. E’ stato pubblicato da Laterza nel gennaio 2010. Due cervelli non in fuga, denunciano la drammatica situazione italiana e cosa fare per uscire dalle secche della crisi. Perché su una cosa non c’è dubbio: se ben gestito, il finanziamento alla ricerca non è un costo ma l’investimento più lungimirante che si possa fare per il futuro del Paese e delle nuove generazioni. “Da più parti – fa notare il prof. Pier Francesco Biagi dell’Università di Bari – si sente dire, e io sono fra questi, che l’intensità della sismicità nel mondo è aumentata. Invece gli esperti di sismologia continuano a sostenere che questo non è vero: ogni anno – dicono – avvengono parecchi terremoti di M=8 nel mondo; la situazione attuale è nella norma; c’è solo la circostanza che alcuni eventi forti si verificano vicino a centri densamente abitati. Questo affermano con sicurezza. Ora, io non mi reputo un sismologo ma un andamento (trend) lo so individuare e capire. Stanco di questo andazzo sono andato nel sito dell’Usgs (ente americano principe in fatto di sismicità mondiale) e mi sono scaricato la tabella della massima magnitudo registrata ogni anno nel mondo a partire dal 1990 ad oggi”. Cos’ha scoperto? “Ho fatto il grafico e ho ricavato il miglior fit lineare dei dati. Bene, il negare che ci sia un aumento dell’intensità della sismicità nel mondo è negare l’evidenza! Allora due sono le possibilità: o gli esperti di sismologia non sanno capire un andamento elementare (e allora è meglio che tornino a scuola) o sono in malafede e dicono il falso (forse per non far preoccupare la gente). Io penso che la gente debba essere informata del vero e non trattata come una manica di ignoranti a cui dire quello che si vuole, anche se contrario all’evidenza. Alcuni miei amici, gente comune non esperta in terremoti, mi dicono spesso che le cose non stiano come dicono gli esperti”. Cioè? “Cioè che è tutto nella norma; mi sembra invece che l’intensità della sismicità sia aumentata”. Cosa sta succedendo nel mondo? “Io da fisico rispondo che hanno ragione e quello che sta succedendo è che siamo in presenza di una fase di massimo; ma cose del genere si sono già verificate nelle ere passate”. Esiste una correlazione tra la sismicità dei Balcani e quella Italiana? “Molti anni fa ho dato una tesi di laurea su questo argomento e il risultato ha dimostrato statisticamente l’esistenza di botta e risposta”. Allora, i terremoti stanno aumentando? “I miei calcoli sono in pratica un’evidente dimostrazione che l’intensità dell’attività sismica mondiale è aumentata negli ultimi anni. In genere la sismicità mondiale è caratterizzata da un andamento ciclico con periodi di massima intensità e periodi di minore intensità; siamo in un periodo di massima. Tutto qui. Nelle ere passate e ancor più vicino nei secoli passati è già successo. A occhio direi che anche la sismicità dell’area mediterranea è in sintonia con l’andamento di quella mondiale. Adesso si fa un gran parlare di radon precursore. Vorrei solo far presente che in Italia (con spirito pioneristico) il mio gruppo di ricerca lavorava e otteneva risultati in questo campo circa trent’anni fa! Alcuni risultati sono stati pubblicati su riviste di prestigio, anche sul GRL. Solo le difficoltà nel reperire finanziamenti e personale ci ha costretto ad interrompere questo filone di ricerca. Ma adesso sono tutti bravi”.