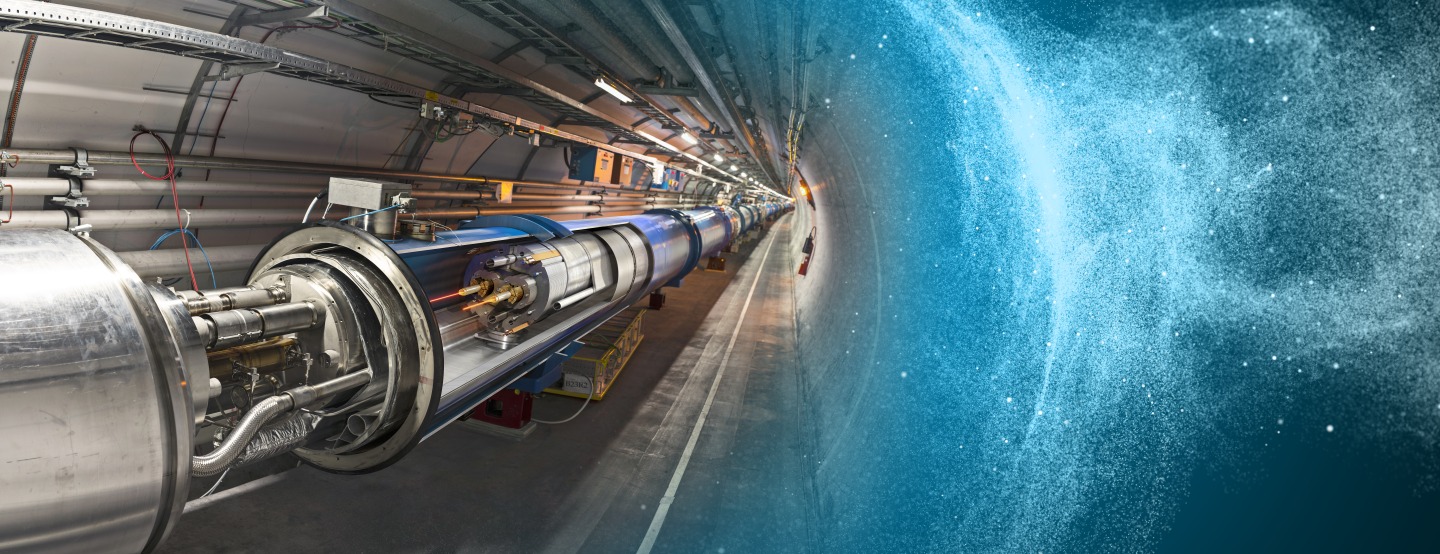

“Eravamo abituati a guardare il cielo e a chiederci quale fosse il nostro posto tra le stelle. Ora ci limitiamo a guardare verso il basso e a chiederci quale sia il nostro posto tra la polvere” (Joseph A. Cooper, Interstellar). Energia! Il Supercollisore di Protoni più grande e potente al mondo, l’Acceleratore di particelle Large Hadron Collider (LHC) del Centro Ricerche Nucleari di Ginevra (Cern), ufficialmente riacceso Giovedì 12 Marzo 2015, nell’Anno Internazionale della Luce, raggiungerà i confini della conoscenza, spingendosi là dove nessuno è mai giunto prima, fino ad energie di 13 TeraElettronVolt (6,5 per fascio, #RestartLHC). Oltre gli 8 TeV (4 per fascio) necessari per scoprire il famoso Bosone di Higgs-Englert nel 2012. È un nuovo inizio per la Fisica particellare come nel colossal Interstellar. Non vi saranno conseguenze catastrofiche per la Terra perché la Natura ha già fatto questi esperimenti. Quella del Cern è quindi la missione più importante della storia dell’Umanità: un viaggio nell’infinitamente piccolo per scoprire le proprietà della Materia e per avere un futuro tra le stelle. I superconduttori di Lhc faranno il loro dovere! Nella ciambella di 27 Km collocata sotto la città di Ginevra in Svizzera, i fasci di Protoni viaggeranno nel super-freddo, a temperature di meno 271 gradi Celsius. L’obiettivo dichiarato dagli scienziati del Cern è chiaro: completare la lista del bestiario particellare elementare previsto dal Modello Standard nel dominio energetico della nostra materia ordinaria (il 5 percento del Tutto), magari con la scoperta del Super-Bosone di Higgs non-Standard di 700 GigaElettronVolt (dovrebbe decadere in due particelle X neutre, teorizzate ma finora non osservate, e poi in due Quark), oltre cinque volte la massa della più leggera “Particella di Dio” individuata nel 2012. Per poi conquistare l’universo delle altre particelle Supersimmetriche, allungando decisamente il passo verso la rilevazione diretta della Materia e dell’Energia Oscure (il 95 percento della Creazione), delle dimensioni spaziotemporali extra, del plasma ad altissima energia (quark e gluoni) studiato dal Dottor Spock in Star Trek, ficcanasando direttamente nel Reame delle particelle più esotiche dell’Universo, nell’Antimateria subnucleare (la “cenere” del Big Bang) e nei “buchi neri” in miniatura che dovrebbero “essere-non-essere” quantisticamente ovunque! Fenomeni mai visti prima. La seconda stagione di Lhc, la più affascinante esplorazione pubblica della Creazione, secondo il crono-programma, durerà tre anni: Lhc in effetti è un Supercollisore totalmente differente dal precedente. Non è facile ottenere dalle collisioni tra fasci di particelle quasi il doppio di energia rispetto al record del vecchio ciclo, per svelare i nuovi segreti della Supermateria. La nuova Superenergia che si raggiungerà potrà consentire ai ricercatori di testare teorie precedentemente non verificate e di esplorare le nuove Frontiere nella Fisica dominate anche dalla famosa equazione di Planck, E=hf. In questi ultimi due anni, centinaia di ingegneri e fisici hanno lavorato sui quattro enormi rivelatori ALICE, ATLAS, CMS e LHCb per prepararli a ricevere la nuova cascata energetica di particelle create dalle collisioni a 13 TeV. I “tappi” di ATLAS sono tornati in posizione, le ruote del rivelatore CMS si sono mosse di nuovo nella configurazione “chiusa”, idem per la grande “porta rossa” dell’esperimento ALICE pronta per il riavvio, mentre la porta di accesso al tunnel LHC è stata sigillata con blocchi di cemento. È la seconda grande stagione di Lhc con la scienziata italiana Fabiola Gianotti che dal 1° Gennaio 2016 entrerà effettivamente in carica come la nuova Direttrice Generale del Cern di Ginevra. Un’impresa scientifica degna di essere immortalata nel colossal Star Trek XIII, magari con un volo speciale nel tempo dell’equipaggio della Flotta Stellare! Perché è altamente probabile, semmai verrà inventato il Motore di Curvatura alle cui equazioni lavorano già migliaia di scienziati di tutta la Terra, che il volo interstellare nascerà qui in Europa grazie anche a questi preziosi studi. Ammirare la complessità degli apparati sperimentali di Lhc, approfondire la storia gloriosa di questo celebre Laboratorio in cui lavorano persone di ogni nazionalità, come in Star Trek, testimoniare che la Scienza è strumento di Pace correttamente interpretando la Logica vulcaniana del Signor Spock, è Cultura. Nei prossimi dieci anni, il Large Hadron Collider raggiungerà progressivamente una luminosità istantanea fino a cinque volte superiore a quella teorica, accumulando nei computer una statistica dieci volte maggiore a quella finora raccolta. L’esplorazione del Supercollisore Lhc è solo all’inizio: il potenziamento dei rivelatori pronti a riprendere dati con un’energia quasi raddoppiata, per dare la caccia a nuove particelle previste dalla maggior parte dei modelli di estensione del Modello Standard, è la premessa del totalmente inatteso. Il programma di Fisica ad alta luminosità (Hl-Lhc) è un atto di Pace considerato di primaria importanza nella Strategia Europea per la Fisica delle particelle e deve essere inteso come il vero motore per lo sviluppo di tecnologie d’avanguardia per l’Umanità. Al Progetto Lhc partecipano 1700 scienziati americani di varie Istituzioni. Gli Usa coprono il 34 percento della capacità computazionale mondiale per l’esperimento ATLAS e il 35 percento per l’esperimento CMS al Fermilab, con operazioni in remoto sui dati acquisiti a Ginevra. Lo spegnimento di Lhc alle ore 7:24 am del 14 Febbraio 2013, al termine della prima stagione di analisi dei dati acquisiti nei primi tre anni di attività, si era reso necessario per un sacco di buone ragioni: gli acceleratori e gli esperimenti dovevano essere potenziati e molte componenti di alta tecnologia riparati e integrati con hardware e software di ultimissima generazione. Per spalancare le porte alla seconda stagione operativa volta alla conquista della nuova frontiera energetica, sono stati sostituiti ben 18 dei 1232 magneti superconduttori che concentrano i fasci di particelle. Più di 10mila interconnessioni elettriche tra i magneti, sono state dotate di derivazioni, pezzetti di metallo che agiscono come percorso alternativo per gli 11mila ampere di corrente, salvando l’interconnessione in caso di guasto. È chiaro che tutta la Macchina lavorerà con più energia, a voltaggio più elevato, per cui tutta l’elettronica è stata consolidata installando nuove resistenze. Anche l’apparato che genera il vuoto, impendendo a molecole estranee di entrare nel Collisore, è stato migliorato, unitamente al sistema criogenico dei magneti superconduttori di Lhc. Aumenterà così la densità dei pacchetti di Protoni in collisione che stavolta saranno temporalmente separati da soli 25 nanosecondi al posto dei consueti 50, ma diminuirà il numero di particelle in ogni singolo pacchetto protonico. Lhc produrrà più collisioni negli esperimenti. Aumenterà la capacità di calcolo per sostenere il flusso dei dati acquisiti dai quattro esperimenti. Il Cern ha acquistato e installato oltre 60mila nuovi microprocessori e 100 petabyte di memoria computazionale addizionale per soddisfare l’appetito di conoscenza della seconda stagione di Lhc. È stato aggiornata significativamente l’intera infrastruttura di comunicazione e di alimentazione dei computer. I magneti superconduttori di Lhc godono di un’altissima efficienza di conducibilità elettrica e di un migliorato sistema di sicurezza, senza la perdita di energia dei nostri elettrodomestici che dissipano calore inquinante in atmosfera contribuendo al Global Warming. La bassissima resistenza consente di produrre forti campi magnetici. Una volta spento, un magnete torna all’originario stato resistivo, rilasciando una grande quantità di energia che il sistema di sicurezza in Lhc riesce a dissipare in modo controllato nel caso di uno sbalzo nel voltaggio dei magneti. Poiché la larghezza del fascio diminuisce con l’incremento di energia, i fasci di particelle in Lhc saranno molto più collimati, il che significa più interazioni e collisioni nell’unità di tempo di Planck. Dunque, verranno prodotti meno Protoni per pacchetto: si passa dai 1.7 per 1011 Protoni dell’Anno Domini 2012 ai 1.2 per 1011 Protoni della seconda stagione. Paradossalmente i computer soffriranno non poco a distinguere le varie particelle create dalle singole dozzine di collisioni istantanee, nonostante i pochi Protoni per ogni interazione. Anche se il problema di “pileup” sarà meno importante rispetto alla prima stagione, i grappoli di Protoni stavolta saranno separati da soli 25 nanosecondi rispetto ai tradizionali 50. Lhc così lavorerà con più particelle per unità di tempo, fornendo più collisioni agli esperimenti. Le cavità a radiofrequenza che offrono alle particelle piccoli “calci” di energia al loro passaggio, opereranno a voltaggio più elevato per potenziare i fasci. Per la manutenzione e l’aggiornamento dei sistemi elettrici di Lhc, si sono resi necessari oltre 400mila test. Il segreto di Lhc è la totale separazione del dispositivo lungo 27 Km dall’atmosfera esterna. Le regioni centrali del cilindro dove avvengono le collisioni di Protoni, devono essere supervuote e superfredde per garantire che i fasci carichi interagiscono solamente tra di loro. Non è semplice visto che i Protoni possono strappare elettroni dalla superficie interna del dispositivo, formando una “nuvola” che interferisce con i fasci. Per prevenire questo fenomeno Lhc è stato internamente rivestito con uno speciale materiale (NEG) che “intrappola” gli elettroni impendendo loro di interagire con i Protoni. Lhc è davvero speciale. È l’unica Macchina nel Sistema Solare a riprodurre in piccolissima scala le energie liberate subito dopo il Big Bang. Dan Brown e associati, sono avvisati. Nulla di preoccupante per la Terra che non è assolutamente in pericolo a causa di Lhc. Semmai una pacifica civiltà aliena dovesse là fuori rilevare le attività del Supercollisore sul nostro mondo, come i Vulcaniani di Star Trek per la prima traccia terrestre di Curvatura prodotta dall’astronave Phoenix di Zefram Cochrane il 5 Aprile 2063 (Star Trek VIII – Primo Contatto), gli alieni dovrebbero discriminare non poco dalle particelle a più alta energia che permeano lo Spazio profondo, come i raggi cosmici di Madre Natura che sono molto più energetici e letali degli esperimenti al Cern di Ginevra! Certamente la sicurezza è fondamentale per gli scienziati che lavorano con Lhc e per i cittadini svizzeri. Al Cern non sono secondi ad alcuno anche nel campo delle misure di sicurezza e di emergenza, alla luce dei nuovi dati sperimentali e teorici. L’LHC Safety Assessment Group (LSAG) ha aggiornato le analisi del 2003 con il lavoro prodotto dall’LHC Safety Study Group, un team di scienziati indipendenti “di controllo”. Ebbene, LSAG conferma ed estende le conclusioni del 2003 Report sul fatto inequivocabile che, nonostante i romanzi, le leggende e i film di serie C in circolazione sulla Terra ambientati al Cern e di fatto altamente disinformativi per il grande pubblico altresì assetato di Scienza e Verità, le collisioni particellari di Lhc non presentano rischi per la salute umana e l’ambiente, e che dunque non vi è ragione alcuna per temere implosioni quantiche in buchi neri artificiali e quant’altro di fintamente fantascientifico! Nulla a che vedere con Star Trek. Quello che i ricercatori fanno con Lhc, è ordinaria amministrazione per la Natura in chissà quanti altri universi e Big Bang oltre il “nostro”. Naturalmente siamo ben lontani dall’Istante Zero della Creazione sotto tutti i punti di vista. È un regime energetico totalmente inaccessibile all’Umanità, anche se le violente energie in azione là fuori non scherzano mica e potrebbero vaporizzarci in qualsiasi istante senza alcun preavviso! Con o senza Lhc. Il Rapporto LSAG è stato controllato e benedetto dal CERN Scientific Policy Committee, un gruppo di scienziati esterni che operano come osservatori e consiglieri del CERN Council. Di recente sono state espresse preoccupazioni infondate su una possibile “reazione di fusione” del carbonio eventualmente attivata da Lhc grazie all’alta concentrazione dei fasci particellari. Anche qui la confusione è alta se si considerano le diversissime scale energetiche in gioco nei nuclei stellari. La sicurezza teorica e fisica dei dispositivi al Cern è stata sempre evidenziata dalle autorità franco-svizzere degli Stati che ospitano il Laboratorio, come dimostra il Memorandum tecnico di Assmann e altri. In estrema sintesi, le reazioni di fusione nucleare possono essere ottenute e mantenute solo in stati altamente densi della materia compressa da una pressione esterna: nelle stelle dalla Gravità della massa, in un ordigno termonucleare da un’esplosione di fissione, in un Tokamak (papà delle future centrali elettriche a fusione) dai campi magnetici, e nel caso di una fusione inerziale dalla potenza di un laser isotropico o dei fasci di particelle altamente focalizzati. Nel caso di Lhc, il flusso residuo è unico dal momento che la direzione delle particelle create ed accelerate è singola. Non esistono pressioni esterne o compressioni, per cui la fusione è impossibile anche per quanto concerne l’azoto eventualmente presente all’interno del tunnel di Lhc. Non esistono “tank” di azoto. E la fusione sarebbe comunque impossibile anche dall’elio liquido superfluido usato per raffreddare i magneti superconduttori di Lhc. Nessun effetto chimico “Bose-Nova”, come dimostra uno studio di Fairbairn e McElrath. Nessuna fusione nucleare dell’elio (usato anche in altri collisori) che è uno degli elementi più stabili in Natura! La sicurezza al Cern è stata dalle migliori Menti sulla Terra, da esperti e premi Nobel di Giappone, Russia e Usa, da astrofisici, cosmologi e matematici. Lhc è sicuro. Ecco alcuni pareri autorevoli: “To think that LHC particle collisions at high energies can lead to dangerous black holes is rubbish. Such rumors were spread by unqualified people seeking sensation or publicity”, osserva Vitaly Ginzburg, Nobel per la Fisica, del Lebedev Institute di Mosca e della Russian Academy of Sciences; “The operation of the LHC is safe, not only in the old sense of that word, but in the more general sense that our most qualified scientists have thoroughly considered and analyzed the risks involved in the operation of the LHC. [Any concerns] are merely hypothetical and speculative, and contradicted by much evidence and scientific analysis”, rivelano i Professori Sheldon Glashow, Nobel per la Fisica, della Boston University, Frank Wilczek, Nobel per la Fisica del Massachusetts Institute of Technology e Richard Wilson, Mallinckrodt Professor of Physics della Harvard University; “The world will not come to an end when the LHC turns on. The LHC is absolutely safe. Collisions releasing greater energy occur millions of times a day in the earth’s atmosphere and nothing terrible happens”, spiega Steven Hawking, Lucasian Professor of Mathematics alla Cambridge University; “Nature has already done this experiment. Cosmic rays have hit the moon with more energy and have not produced a black hole that has swallowed up the moon. The universe doesn’t go around popping off huge black holes”, osserva il Professor Edward Kolb, Astrofisico della University of Chicago; “I certainly have no worries at all about the purported possibility of LHC producing microscopic black holes capable of eating up the Earth. There is no scientific basis whatever for such wild speculations”, rileva Sir Roger Penrose, Former Rouse Ball Professor of Mathematics della Oxford University; “There is no risk [in LHC collisions, and] the LSAG report is excellent”, conferma il Professor Lord Martin Rees, UK Astronomer Royal e President of the Royal Society of London; “Those who have doubts about LHC safety should read LSAG report where all possible risks were considered. We can be sure that particle collisions at the LHC cannot lead to a catastrophic consequences”, osserva V.A. Rubakov dell’Institute for Nuclear Research di Mosca e della Russian Academy of Sciences; “We fully endorse the conclusions of the LSAG report: there is no basis for any concerns about the consequences of new particles or forms of matter that could possibly be produced at the LHC”, spiegano R. Aleksan et al., i 20 membri esterni del CERN Scientific Policy Committee, insieme al Professor Gerard ‘t Hooft, Nobel per la Fisica; “We discussed the logically possible black hole evolution paths. Then we discussed every single outcome of those paths and showed that none of the physically sensible paths can lead to a black hole disaster at the LHC”, rivelano il Dr. Koch, il Prof. Bleicher e il Prof. Stoecker della Frankfurt University e della GSI di Darmstadt. Gli Atti sono di pubblico dominio. Senza segreti. Lhc, come altri acceleratori e collisori di particelle, si limita a ricreare nella piccola scala i fenomeni naturali dei raggi cosmici, nelle condizioni controllate di un laboratorio, per consentirne lo studio. I raggi cosmici sono particelle di alta energia prodotte nello spazio profondo, alcune delle quali accelerate naturalmente (anche da stelle nere!) fino a energie impossibili anche per Lhc. Negli ultimi 70 anni i raggi cosmici che investono l’atmosfera terrestre sono stati analizzati in gran dettaglio in moltissimi esperimenti. Per miliardi di anni la Natura ha prodotto così tante collisioni di raggi cosmici sulla Terra, che neppure un milione di Supercollisori come Lhc potrebbe eguagliare. Eppure la Terra esiste ancora. Gli Astronomi (non gli astrologi) osservano un enorme numero di vasti oggetti nell’Universo regolarmente investiti dai raggi cosmici che distruggono ma anche creano le condizioni per la Vita. Madre Natura conduce ogni secondo più di 10 milioni di milioni di esperimenti simili a Lhc, ovunque attorno a noi. Eppure ancora esistiamo grazie a Dio. È sorprendente che la possibilità di un’imprevedibile estinzione di massa sulla Terra e altrove, contraddica apertamente l’evidenza dei fatti e dei fenomeni finora osservati su galassie, stelle e pianeti che possono esistere nonostante questo incessante bombardamento di particelle mortali. La Natura è capace di tutto: forma buchi neri laddove un istante prima c’era una stella massiccia, poco più grande del nostro Sole, collassata sotto il suo stesso peso a causa della fine delle reazioni termonucleari. I buchi neri concentrano una grande quantità di massa-energia in uno spazio molto piccolo. Teorie sui buchi neri microscopici potenzialmente osservabili in Lhc, si riferiscono in verità a particelle esotiche prodotte nelle collisioni di coppie di Protoni, in interazioni ognuna delle quali ha un’energia comparabile a quella di una mosca in volo. Nulla a che vedere con i buchi neri di taglia stellare, molto più densi e pesanti che non potrebbero mai essere prodotti in Lhc. Secondo le proprietà note della vera Forza di Gravità (nulla a che vedere con il film Gravity pluripremiato da Hollywood rispetto al più sensato Interstellar) descritta da Albert Einstein nella sua Teoria della Relatività, è impossibile produrre buchi neri microscopici in Lhc. Tuttavia, la bizzarra, strana, suggestiva e maliziosa Logica quantistica matematica, consente di fare ben altro: esistono infatti teorie speculative che prevedono la produzione in Lhc di particelle esotiche in grado di esistere nel nostro Universo solo per pochissimi istanti prima di disintegrarsi. I buchi neri classici in senso stretto, quindi, non avrebbero il “tempo” per mangiare la massa-energia della Terra e causare l’estinzione che rientra nella categoria degli effetti macroscopici. Sebbene la teoria predica che i buchi neri microscopici decadano rapidamente, anche gli ipotetici buchi neri stabili possono essere dimostrati innocui dallo studio delle conseguenze della loro produzione attraverso i raggi cosmici naturali. Altrimenti dovremmo essere già tutti estinti. Senza Lhc. Mentre le collisioni artificiali al Cern di Ginevra differiscono enormemente da quelle naturali dei raggi cosmici su oggetti di taglia astronomica come la Terra, le nuove particelle prodotte dalle collisioni di Lhc tendono a muoversi più lentamente rispetto a quelle nate dai raggi cosmici. Questa è la migliore dimostrazione possibile della loro intrinseca sicurezza per l’Umanità che, guardando nell’infinitamente piccolo, cerca di spiccare il volo verso le altre stelle perché la Terra ha una data di scadenza naturale. Le ragioni specifiche di questo fenomeno dipendono dal fatto che i buchi neri siano elettricamente carichi o neutri. La maggior parte dei buchi neri stabili ci si aspetta che siano carichi, poiché creati da particelle cariche. In tal caso dovrebbero interagire con la materia ordinaria ed essere fermati mentre attraversano la Terra o il Sole, se prodotti dai raggi cosmici o da Lhc. Il fatto che la Terra e il Sole siano ancora qui esclude categoricamente che i raggi cosmici o Lhc possano mai produrre mortali buchi neri microscopici elettricamente carichi. Se i buchi neri microscopici non avessero carica elettrica, le loro interazioni con la Terra sarebbero molto deboli. Quelli prodotti dai raggi cosmici potrebbero attraversare in maniera innocua la Terra e lo spazio, mentre quelli prodotti da Lhc potrebbero rimanere sulla Terra. Tuttavia esistono oggetti astronomici più grandi e densi della Terra nell’Universo. I buchi neri prodotti nelle collisioni di raggi cosmici con corpi celesti come stelle di neutroni e nane bianche, sarebbero portati a riposo. L’esistenza di oggetti così densi esclude la possibilità che Lhc possa produrre buchi neri catastrofici. “Strangelet” è il termine coniato per l’ipotetico grumo microscopico di “materia strana” contenente numeri quasi eguali di particelle chiamate Quark “up”, “down” e “strange”. In accordo con i fisici teorici, le “strangelet” dovrebbero cambiare in materia ordinaria in meno di un miliardesimo di secondo. Ma potrebbero le “strangelet” accoppiarsi con la material ordinaria e cambiarla in “materia strana”? La questione fu sollevata inizialmente nel 2000, prima della messa in funzione del Relativistic Heavy Ion Collider (RHIC) negli Usa. Un studio dell’epoca mostrò che non c’era alcun motivo per allarmarsi e la Macchina RHIC è ancora alla ricerca delle “strangelet” finora mai rilevate. Anche Lhc farà collidere fasci di nuclei pesanti come fanno gli americani con RHIC. Tuttavia Lhc è oggi molto più potente del Collisore RHIC e la maggiore energia dei fasci di particelle rende ancora meno probabile l’esistenza delle “strangelet”. È difficile per la “materia strana” stare insieme alle alte temperature prodotte da simili collisori, come per un cubetto di ghiaccio formarsi nell’acqua bollente. Inoltre i Quark saranno più diluiti in Lhc rispetto al collega americano RHIC, rendendo più complessa la creazione della “materia strana”. La produzione di “strangelet” in Lhc al Cern di Ginevra appare quindi meno probabile che al RHIC e gli esperimenti finora confermano tutte le argomentazioni che smentiscono la creazione artificiale di “strangelet” a Ginevra. L’analisi della prima stagione di dati dalle collisioni di nuclei pesanti in Lhc verifica gli ingredienti chiave usati nel Rapporto LSAG per valutare il limite superiore nella produzione delle ipotetiche “strangelet”. Non mancano altresì teorie sul fatto che l’Universo non sia più così stabile come finora pensato e che, per tali ragioni, le eventuali “perturbazioni” causate da Lhc sulla Terra potrebbero far ribaltare il Creato letteralmente in uno stato più stabile, chiamato Bolla di Vuoto, nel quale però non potremmo più esistere. Se Lhc fosse capace di tanto, allora anche le collisioni naturali di raggi cosmici potrebbero prima o poi far finire l’Universo. Dal momento che le bolle di vuoto non sono state mai prodotte nel Cosmo visibile, altrimenti non saremmo qui a certificarlo, allora neppure Lhc potrebbe fare altrettanto. I Monopoli Magnetici sono particelle ipotetiche dotate di una singola carica magnetica, quella “nord” o “sud” di una calamita che le ha entrambe. Alcune teorie suggeriscono che, se esistessero, i Monopoli Magnetici potrebbero causare il decadimento dei Protoni. Un esperimento al Laboratorio Nazionale del Gran Sasso dell’Infn in Abruzzo (fondato dal Professor Antonino Zichichi) alcuni anni fa, pur non rilevandoli, ne determinò alcuni parametri limite interessanti. Le teorie sostengono inoltre che i Monopoli sarebbero troppo pesanti per poter essere prodotti in Lhc. D’altra parte se fossero così leggeri da essere rilevati al Cern, i raggi cosmici che colpiscono regolarmente l’atmosfera della Terra potrebbero creare Monopoli Magnetici che il nostro pianeta fermerebbe in maniera efficace, intrappolandoli. Ma non sono stati ancora scoperti e l’esistenza della Terra conferma che la produzione in Lhc di famelici leggeri Monopoli Magnetici “ammazza Protoni” è da escludere a priori. Il 4 Luglio 2012, gli esperimenti ATLAS e CMS in Lhc al Cern hanno confermato la scoperta del Bosone di Higgs, una particella con una massa di 126 GigaElettronVolt. Il Campo di Higgs è la manifestazione più semplice del Meccanismo di Brout-Englert-Higgs che dà la massa a tutte le particelle. Sembra essere la particella finale nel Modello Standard Model, la teoria che spiega le interazioni tra le particelle e le forze fondamentali della Natura, ad essere stata verificata sperimentalmente. L’incremento di energia in Lhc aumenta le chance di creare Bosoni di Higgs nelle collisioni, il che significa maggiori opportunità per i ricercatori di misurare il Campo di Higgs con grande precisione e di provare l’esistenza di decadimenti rari finora mai osservati, evidenziando le sottili differenze nascoste nel Bosone che il Modello Standard prevede. Esistono poi particelle che non possono essere osservate perché non interagiscono nel nostro Universo essendo trasparenti alla forza elettromagnetica. È la caccia alle particelle esotiche oscure dotate di grande massa che interagiscono con il Campo associato al Bosone di Higgs, la grande sfida per Lhc. La Materia Oscura gravitazionale non avrà più segreti? Le particelle Supersimmetriche, controparte di quelle note nel Modello Standard, potranno essere evidenziate se esistono, perché l’alta energia dei fasci in Lhc lo consente. La teoria finora incompleta ha bisogno di ulteriori “pezzetti” per essere completata? Oppure occorre rimettere tutto in gioco, finanche il Modello Standard? La caccia alla Supermateria e alla Superenergia è quanto mai aperta. Lhc dovrà illuminare queste nuove particelle se esistono, gettando uno sguardo sulle altre Dimensioni della Realtà. Perché la Gravità è, tra le quattro forze fondamentali, la più debole? Forse non è così forte perché estende il suo influsso sulle altre Dimensioni extra dell’Universo. Lhc dovrà dimostrarlo scoprendo le particelle che possono esistere solo se le altre Dimensioni esistono davvero. Le teorie che le prevedono sono molte. Come abbiamo atomi di diverso stato (alto o basso) energetico, così potrebbero esistere versioni più pesanti delle particelle standard in altre Dimensioni. Occorre poi unificare la Relatività Generale e la Gravità quantistica. Il Big Bang ha creato sia la Materia sia l’Antimateria. Ma che fine ha fatto quest’ultima? Ammesso e non concesso il contrario. L’annichilazione avrebbe dovuto distruggere tutto. Così non è stato a causa di un leggero “delta” che ha favorito una delle due. Lhc aiuterà i fisici a capire le proprietà dell’Antimateria nucleare e atomica, peraltro prodotta al Cern, per risolvere il mistero delle differenze rispetto alla materia ordinaria. Pochi milionesimi di secondo dopo il Big Bang, l’Universo iperdenso e ipercaldo era zuppa particellare che si muoveva alla velocità della luce, dominata dai Quark, i mattoni fondamentali della materia, e dai Gluoni, la Colla responsabile della trasmissione della Forza Forte che lega i Quark nei Protoni, nei Neutroni e nei Mesoni. In quei primi evanescenti infernali istanti della Creazione, Quark e Gluoni interagivano ancora debolmente, liberi di muoversi in quello che i fisici chiamano Plasma di Quark e Gluoni. Le più alte energie di Lhc consentiranno di caratterizzare meglio questo stato fondamentale dell’Universo. Introdotti nel 1964 da Murray Gell-Mann, i Quark sono particelle alquanto peculiari, che non possono essere osservate direttamente, ma di cui si hanno solo indizi indiretti. Oggi sappiamo che, assieme ai leptoni, essi rappresentano i costituenti elementari della materia. Tuttavia, i Quark come sono concepiti dalle moderne teorie delle interazioni fondamentali, sono oggetti piuttosto diversi dai Quark di Gell-Mann. Per dare una risposta al problema della proliferazione delle particelle fortemente interagenti, gli Adroni, nel 1961 il fisico Gell-Mann suggerì che l’interazione forte potesse avere una simmetria descritta matematicamente dal gruppo SU(3), cioè che restasse invariata sotto le trasformazioni di questo gruppo. Il modello di Gell-Mann riuscì a fare ordine nella congerie degli Adroni noti all’epoca (molte decine) e fu in grado di descrivere con successo la loro fenomenologia. Ma perché la simmetria è proprio SU(3)? Una possibile risposta è che gli Adroni non sono particelle elementari, ma stati legati di oggetti più piccoli, i Quark appunto, e delle loro antiparticelle, gli Antiquark. Gell-Mann ipotizzò tre tipi, o “sapori”, di Quark (up, down e strange), e la simmetria SU(3) è quella che scambia i sapori. Le regolarità osservate nelle masse degli Adroni e nei loro processi sono conseguenza del fatto che l’interazione forte è invariante del tutto o in parte sotto questo scambio. Gli esperimenti che hanno rivelato la presenza di costituenti elementari all’interno del Protone rientrano in un modello di esplorazione della materia che ha una lunghissima storia ed è basato su un’idea molto semplice: studiare la struttura di un sistema sparandogli contro delle particelle e osservando come queste vengono diffuse. I tre elementi base di questa classe di esperimenti sono un fascio di particelle che fungono da proiettili, un bersaglio e un rivelatore. Il bersaglio è costituito dal sistema che si intende studiare (atomi, nuclei, protoni). Le particelle-proiettili sono elementari, cioè prive di struttura interna, come gli elettroni, i muoni o i neutrini, o si comportano come tali. Il rivelatore è posto dietro e attorno al bersaglio e segnala l’arrivo delle particelle diffuse, contandole ed effettuando una serie di misure (identificazione del tipo di particella, misura dell’energia). Fu con un apparato di questo genere che stava tutto su un tavolo da laboratorio che nel 1909 Hans Wilhelm Geiger ed Ernest Marsden, collaboratori di Ernest Rutherford, scoprirono il nucleo atomico. I due fisici osservarono che, inviando un fascio di particelle alfa, che oggi sappiamo essere costituite da due protoni e due neutroni, ma che nell’urto rimanevano intatte ed erano quindi assimilabili a corpuscoli elementari, su lamine di vari metalli, un certo numero di particelle subiva una notevole deflessione. Persino un sottilissimo foglio d’oro, dello spessore di mezzo millesimo di millimetro, era in grado di deviare alcune particelle di più di 90 gradi. Rutherford capì che ciò era dovuto al fatto che le particelle urtavano contro un oggetto molto piccolo posto al centro dell’atomo, il nucleo, che concentrava in sé quasi tutta la massa atomica. I primi esperimenti di diffusione di elettroni su atomi furono compiuti negli Anni Trenta del XX Secolo. Da allora questo tipo di esperimenti ha permesso di esplorare anche la struttura dei nuclei e dei nucleoni (protoni e neutroni). Negli Anni Cinquanta, Robert Hofstadter scoprì in questo modo che i nucleoni non sono oggetti puntiformi, ma sferette composite di raggio pari a circa un Fermi, ossia 10 alla meno 15ma potenza in metri. Con elettroni di più alta energia, alla fine degli Anni Sessanta, i fisici dello Slac in California rivelarono l’esistenza dei Quark all’interno del Protone. Il processo studiato allo Slac, e in seguito con precisione crescente al Cern di Ginevra e all’acceleratore Hera di Amburgo, è la cosiddetta diffusione profondamente anelastica, in cui il Protone bersaglio si frammenta in una miriade di particelle che non vengono osservate. Le sole particelle osservate sono gli elettroni diffusi e, come negli esperimenti di Geiger e Marsden, il cospicuo numero di elettroni deflessi a grandi angoli segnala la presenza di corpuscoli più piccoli all’interno del Protone: i Quark. Esistono davvero i Quark? Se sì, dovrebbero essere relativamente facili da individuare, perché hanno una carica elettrica pari a multipli di un terzo della carica dell’elettrone, mentre tutte le particelle note hanno carica pari a multipli interi della carica dell’elettrone. Eppure, i Quark liberi sono stati cercati dappertutto, ma non sono mai stati trovati A partire dalla seconda metà degli Anni Sessanta, la presenza di costituenti puntiformi all’interno dei protoni fu rivelata da una serie di esperimenti di diffusione profondamente anelastica. Dove l’urto di un elettrone di alta energia su un protone produce uno stato finale che contiene un gran numero di particelle che non vengono rivelate. Sperimentalmente si studia solo la distribuzione angolare degli elettroni deflessi. Ci si sarebbe aspettati, immaginando il protone come una sferetta uniformemente carica, che la probabilità di osservare questi elettroni diminuisse molto rapidamente al crescere del loro angolo di deflessione. Invece, si trovò che, per angoli sufficientemente grandi ed energie sufficientemente alte, essa diventava circa costante. Nel 1968 Feynman osservò che ciò poteva essere spiegato supponendo che l’urto avvenisse tra l’elettrone e costituenti elementari (senza struttura interna) e quasi liberi, ossia tali da non accorgersi di essere all’interno di un protone. È stato naturale pensare che questi costituenti, che Feynman battezzò Partoni, potessero essere identificati con i Quark. In effetti, da questa identificazione seguirono diverse predizioni sperimentali, che furono in seguito verificate con crescente precisione. La deduzione sembra paradossale. Da un lato, è impossibile osservare i Quark liberi, il che suggerisce che, se esistono, sono così fortemente legati che l’energia necessaria per spezzare un protone nei suoi costituenti è infinita. Dall’altro, vi sono evidenze della presenza di Quark all’interno del protone, i quali però si comportano come quasi liberi, ossia molto debolmente legati. Questa apparente contraddizione è risolta dalla Cromodinamica Quantistica (QCD, Quantum ChromoDynamics), la teoria delle interazioni forti, in cui i Quark e gli Antiquark interagiscono con le particelle mediatrici della interazione forte, i Gluoni, analogamente a come nell’elettromagnetismo gli elettroni interagiscono con la luce, cioè con i fotoni che sono particelle mediatrici dell’interazione elettromagnetica. Una delle caratteristiche della QCD, infatti, è che l’interazione tra Quark e Gluoni, pur avendo la stessa forma a tutte le distanze, si attenua al diminuire della distanza a cui viene sondata. O, equivalentemente, all’aumentare dell’energia e tende ad annullarsi a distanze infinitamente piccole, cioè a energie infinitamente elevate. È il fenomeno noto come libertà asintotica. Ecco perché negli urti di elettroni di alta energia, i Quark appaiono come oggetti molto poco interagenti, pressoché liberi. In una teoria quantistica dei campi come la QCD anche le entità fisiche cambiano al variare della risoluzione con cui vengono osservate. Questo vuol dire che un oggetto che, osservato con bassa risoluzione, ossia a bassa energia, può apparire come un singolo Quark, visto con una risoluzione più alta, ossia ad alta energia, si rivela essere in realtà un coacervo di molti Quark, Antiquark e Gluoni. Ciò permette di chiarire il vero significato dei Quark di Gell-Mann. Questi sono solo indirettamente legati ai Quark puntiformi della QCD: si tratta infatti di oggetti compositi. Hanno le stesse cariche dei Quark della QCD, ma le interazioni tra di essi sono descritte da una diversa teoria che si ottiene dalla QCD nel limite di basse energie, cioè quando il Protone viene “sondato” con bassa risoluzione. Il Protone è fatto da tre Quark di Gell-Mann, che in esperimenti di alta energia si rivelano essere composti da infiniti Quark, Antiquark e Gluoni: sono questi, in ultima analisi, i mattoni fondamentali della materia. Nel corso degli ultimi vent’anni la QCD nel regime delle alte energie ha portato a predizioni sempre più precise, che sono state verificate sperimentalmente con grande accuratezza. È questa la teoria alla base degli esperimenti che hanno portato alla scoperta del Bosone di Higgs nelle collisioni tra protoni nell’acceleratore Lhc del Cern. Infatti, una descrizione accurata della sottostruttura del Protone è un ingrediente indispensabile per ottenere predizioni per qualunque processo in Lhc. Questa informazione è codificata nelle distribuzioni partoniche che forniscono la probabilità di trovare all’interno di un Protone i vari tipi di Quark e Antiquark, e i Gluoni. Dal punto di vista della QCD, la simmetria SU(3) di Gell-Mann, cioè l’invarianza rispetto al cambiamento di sapore dei Quark “up”, “down” e “strange”, risulta essere una proprietà accidentale, dovuta al fatto che questi Quark sono tutti e tre molto più leggeri del Protone. La simmetria fondamentale della QCD, quella che determina le leggi dell’interazione forte, è un’altra simmetria di tipo SU(3), ma riguardante una diversa proprietà dei Quark, anch’essa immaginata nel 1964: il colore. La fisica fondamentale abbonda di “simmetrie” dai nomi strani: U(1), SU(2), SU(3). Una simmetria è una proprietà di invarianza delle leggi di Natura rispetto a certe trasformazioni che possono essere spaziotemporali (rotazioni, cambiamenti del sistema di riferimento, ecc.) o interne (cambiamenti di certe proprietà intrinseche delle particelle, come la carica elettrica, il colore, il sapore). Dal punto di vista matematico, un insieme di trasformazioni di simmetria ha la struttura di un gruppo, e le sigle indicano per l’appunto dei gruppi di simmetria. Per illustrare il concetto di gruppo di trasformazioni, si considerino due rotazioni nel piano. Se si effettua di seguito prima l’una e poi l’altra, il risultato finale sarà equivalente a quello di una terza rotazione: in altri termini, componendo due rotazioni si ottiene ancora una rotazione. Questa proprietà dell’insieme delle rotazioni è chiamata Chiusura. Se componiamo una rotazione di 30 gradi con una rotazione di 60 gradi, otteniamo una rotazione di (30+60 gradi) = 90 gradi. Ogni rotazione ne ammette una inversa, cioè una rotazione che, per così dire, riporta le cose al punto di partenza, annullando l’effetto della prima. Data una rotazione in senso orario di 45 gradi, la rotazione inversa sarà una rotazione in senso antiorario di 45 gradi. Effettuare prima l’una e poi l’altra, equivale a non effettuare alcuna rotazione o, come si dice, a effettuare una rotazione identica. L’identità è una trasformazione particolare che non trasforma nulla, cioè lascia tutto com’è. Questo discorso può essere esteso a qualunque tipo di trasformazione. Se le trasformazioni di un sistema godono delle proprietà illustrate (chiusura, esistenza dell’identità ed esistenza dell’inverso) si dice che quelle trasformazioni formano un gruppo. Tutte le trasformazioni di simmetria della fisica formano dei gruppi. In particolare, le simmetrie interne sono associate in genere a gruppi che in gergo matematico sono chiamati “unitari” o “speciali unitari” e indicati con le lettere U e SU seguite da un numero in parentesi, che è legato al numero di parametri necessari a descrivere le trasformazioni del gruppo. La simmetria di Gell-Mann è di tipo SU(3) ed è chiamata anche simmetria di sapore, perché è una simmetria approssimata delle interazioni forti rispetto al cambiamento del sapore, cioè del tipo dei Quark leggeri “up”, “down” o “strange”. Le simmetrie unitarie più importanti sono le simmetrie di Gauge, quelle alla base delle teorie fondamentali delle forze. La forza elettromagnetica è basata su una simmetria di Gauge di tipo U(1), legata alla carica elettrica, la forza debole su una simmetria di Gauge SU(2) che è rotta spontaneamente dal Meccanismo di Higgs. La forza forte possiede una simmetria di Gauge esatta, matematicamente di tipo SU(3) come la simmetria di Gell-Mann, ma legata alla carica di colore dei Quark e perciò detta simmetria di colore. La caccia ai Quark liberi ha inizio con l’idea stessa di Quark. Fu l’ideatore dei Quark, Murray Gell-Mann, a proporre per primo di verificare l’ipotesi secondo cui non esisterebbero Quark isolati, non associati ad altri Quark, cercando alle più alte energie prodotte dai grandi acceleratori. I primi esperimenti portano la data del 1964 e furono compiuti al protosincrotrone del Cern e all’acceleratore Ags del Brookhaven National Laboratory, i quali, lavorando alle alte energie dell’epoca, centinaia di volte inferiori a quelle ottenute oggi da Lhc, permettevano di rivelare nuove particelle in una camera a bolle. I risultati, come Gell-Mann stesso si aspettava, furono negativi. Da allora, gli scienziati non hanno mai smesso di cercare i Quark liberi, nonostante nessuno si aspetti davvero di trovarli. Sembra che a rendere appetitosa la sfida sia proprio quel pregiudizio iniziale: se invece esistessero, da qualche parte, nascosti in un luogo diverso da quello in cui si è cercato? Componenti della maggior parte delle particelle, e quindi dei nuclei degli atomi, i Quark hanno cariche elettriche pari a un terzo o a due terzi di quella dell’elettrone. Se esistessero in forma libera, cioè slegati da altri quark, si dovrebbero poter misurare cariche frazionarie di questo valore, ma fino ad oggi nessun esperimento ha mai osservato cariche frazionarie: i Quark sembrano presentarsi sempre in associazione con altri Quark o Antiquark, confinati in stati legati a gruppi di due o di tre, dando luogo a cariche intere. Concepire un esperimento per trovare Quark liberi è quindi un’impresa coraggiosa, anche perché le aspettative degli scienziati possono influenzare l’analisi dei dati e il loro risultato. Lo scenario non è quindi molto incoraggiante e forse è questo a rendere la sfida ancora più eccitante. L’esperimento più famoso sulla ricerca dei Quark liberi è certamente quello che William Fairbank e i suoi colleghi della Stanford University condussero nel 1977. La fama dell’esperimento di Fairbank si deve al fatto che è stato l’unico nella storia ad avere riportato risultati positivi sull’esistenza di cariche frazionarie, che si sarebbero potute associare naturalmente ai Quark. L’esperimento non utilizzava la tecnologia dei grandi acceleratori, prendeva spunto piuttosto dal lavoro del fisico Robert Millikan che con il famoso esperimento delle gocce d’olio fu in grado di rivelare e misurare quella che per tutti oggi è l’unità elementare della carica elettrica della materia, la carica dell’elettrone. E come avverrebbe oggi se fossero scoperti i Quark isolati, questo risultato consegnò a Millikan il premio Nobel per la Fisica nel 1923. Fairbank e colleghi sostituirono alle gocce d’olio delle sfere di niobio, un materiale superconduttore, tenendole in sospensione sfruttando la levitazione magnetica per bilanciare la Gravità. Dopo avere monitorato accuratamente il modo in cui le singole sfere si muovevano sotto l’effetto di un campo elettrico variabile, il gruppo di Fairbank affermò di avere misurato la presenza di cariche frazionarie pari a +1/3 e -1/3 dell’unità di carica elettrica. Dopo la pubblicazione di questo risultato, il fisico statunitense Luis Alvarez, premio Nobel nel 1968, animato da giustificato sospetto, suggerì di ripetere l’esperimento facendo un’analisi “alla cieca” dei dati ottenuti, aggiungendo cioè valori casuali e sconosciuti alle cariche elettriche misurate, in modo che chi conduceva l’esperimento non conoscesse il reale valore delle singole cariche fino al completamento dell’analisi dei dati. Metodi analoghi sono applicati anche oggi, nei moderni esperimenti, per evitare che la pressione di eventuali pregiudizi condizioni l’analisi e porti a una falsa interpretazione dei dati, facendo emergere forzatamente il risultato atteso. È la Logica quantistica del Signor Spock. La procedura fu applicata a un nuovo insieme di dati dell’esperimento di Fairbank e, quando l’analisi fu conclusa, il valore dei numeri casuali fu reso pubblico e sottratto alle cariche misurate. Dopo l’apertura (unblinding) l’esito dell’esperimento non mostrava più la quantizzazione della carica a +1/3 o -1/3. L’analisi alla cieca, portava quindi a risultati in disaccordo con quanto pubblicato da Fairbank: non c’era alcuna evidenza di cariche frazionarie libere. Già alcuni anni prima, a partire dal 1966 e per una quindicina di anni a seguire, era stata condotta anche a Genova, dal fisico Giacomo Morpurgo, una lunga sperimentazione che sfruttava la levitazione magnetica di piccole sfere e grani di grafite, senza che fosse mai osservato il minimo segnale della presenza di cariche elettriche frazionarie libere. È ormai opinione comune che l’esperimento di Fairbank sia stato affetto da qualche influenza esterna, forse un “effetto di fondo” magnetico, e che dunque non abbia realmente osservato QQuark liberi. Ma le gocce d’olio di Millikan hanno continuato a ispirare i fisici anche dopo l’esperienza di Fairbank. Sempre con l’idea di verificare la presenza di cariche frazionarie, la sola firma possibile dell’esistenza dei Quark liberi, nel 1996 un gruppo di ricercatori condotto da Martin Perl ripropose nei laboratori americani dell’acceleratore Slac di Stanford l’esperimento delle gocce d’olio. La prova condotta da Perl ripercorreva quello di Fairbank, con poche ma significative differenze: l’uso di uno stroboscopio e di una videocamera permise al gruppo di monitorare automaticamente milioni di gocce, ottenendo valori molto precisi del diametro di ogni goccia, della loro velocità finale e della carica elettrica. In tutto, l’esperimento mostrò che, se ci fossero Quark isolati con cariche ±1/3 o ±2/3, allora questi sarebbero presenti in quantità inferiori a uno su centinaia di miliardi di miliardi di protoni e neutroni. Questo non permette di affermare che i Quark liberi non esistono, e la cosa è per definizione impossibile da dimostrare sperimentalmente. Risultati come quello di Perl consentono soltanto di concludere che è molto improbabile che i Quark isolati esistano o che, se esistono, sono estremamente rari. Nel 1964, poco dopo che fu postulata l’esistenza dei Quark da Gell-Mann e Zweig, Wally Greenberg avanzò l’ipotesi che i Quark possedessero un’ulteriore proprietà nascosta che poteva assumere tre valori distinti. In altre parole, il numero di Quark nella teoria di Gell-Mann e Zweig doveva essere triplicato. Dovevano esistere perciò tre Quark distinti di tipo “up”, tre di tipo “down” e tre di tipo “strange”. Mentre i Quark di tipo “up” e “down” differiscono tra di loro per la carica elettrica, e lo “strange” differisce dall’up e dal down per la massa e la stranezza, nessuna ulteriore differenza fisica doveva essere associata a questa nuova proprietà. Che fu chiamata “colore”, in quanto esistono tre colori primari sulla Terra. È bene chiarire però che questo “colore” non ha niente a che vedere con la nostra percezione fisiologica del colore. Al posto di blu, verde e rosso, avremmo potuto usare un indice numerico, ed è infatti questo che appare nelle equazioni che governano la dinamica dei Quark. La tendenza a utilizzare nomi bizzarri e poco appropriati nella fisica delle particelle elementari è illustrata da Richard Feynman che scrive: “Quegli idioti dei fisici, ormai incapaci di farsi venire in mente una bella parola greca, hanno chiamato questo tipo di polarizzazione con l’infelice parola ‘colore’, che non ha niente a che vedere con il colore di senso comune”. La necessità del colore è bene esemplificata dall’esistenza della “Δ++”, una particella costituita da tre Quark di tipo “up”. I Quark, come gli elettroni, obbediscono al principio di esclusione di Pauli, che sancisce che non vi possono essere due Quark nello stesso stato. Nella “Δ++” anche la proprietà dello spin è identica per i tre Quark, e ciò farebbe pensare che vi debba essere una violazione del principio di Pauli. Ammettendo invece l’esistenza del colore, si può assumere che i tre Quark “up” abbiano colori diversi tra loro, rispettando così il principio di Pauli. Nonostante l’aspro giudizio di Feynman, una certa analogia tra il colore dei Quark e il colore di senso comune esiste. Se è vero infatti che questa proprietà dei Quark, detta più correttamente carica di colore, non ha nulla a che vedere con i colori che percepiamo con i nostri occhi, ossai la luce di diversa lunghezza d’onda, le regole matematiche con cui i colori si sommano sono molto simili a quelle con cui si accoppiano i Quark. Con soli tre colori fondamentali (rosso, verde e blu, in inglese la terna: red, green e blue, RGB) possiamo costruire tutti i colori, basta sommarli con un’opportuna combinazione. Funziona così lo schermo del computer: assegnando il valore zero a tutti e tre i colori (0,0,0) otteniamo il nero, assegnando il valore massimo permesso (MB,MG,MR) otteniamo il bianco e il viola si ottiene con la combinazione (MB,0,MR). Le particelle adroniche, cioè quelle fatte di Quark, non possiedono una carica complessiva di colore. Semplificando la matematica dei colori quantistici, che è molto più complessa, si possono descrivere i Barioni come formati da tre Quark di colore diverso. I Mesoni, invece, possiamo immaginarli come coppie formate da un Quark di un colore e un Antiquark che ha colore complementare, cioè quello che neutralizza il corrispondente colore primario. Per definizione, nei colori ordinari il complementare del rosso è il ciano, del verde il magenta e del blu il giallo. Anche i colori complementari formano una terna (CMY, cyan, magenta, yellow) molto usata nella stampa su carta. Ma in questo caso la sovrapposizione dei colori genera il nero! Quest’analogia permette di fare ancora un passo in più: si possono descrivere l’Antiprotone e l’Antineutrone come formati da tre Antiquark che portano altrettanti anticolori. La matematica dei colori e degli anticolori permetterebbe di formare sistemi ancora più complessi come il Tetraquark (due Quark e due Antiquark) forse osservato di recente, e il Pentaquark (quattro Quark e un Antiquark) finora mai osservato. Dal fatto che differenze di colore non implicano differenze di altre proprietà fisiche, segue che esiste un’invarianza delle leggi fisiche sotto una permutazione del colore. Nel mondo microscopico dei quanti, tuttavia, tale invarianza risulta più ampia e complessa. La meccanica quantistica insegna infatti che non solo è possibile che un sistema abbia valori definiti di una certa grandezza, ma che è anche possibile che il sistema sia in una sovrapposizione di stati con valori diversi di questa grandezza, con ciascuna componente avente un peso diverso. Si può ricorrere all’analogia con un punto dello spazio, che è caratterizzato, in coordinate cartesiane, dalle sue componenti X, Y e Z. Analogamente lo stato di colore di un Quark è caratterizzato dalle sue componenti di colore blu, verde e rosso. Le leggi fisiche sono invarianti, oltre che sotto una permutazione del colore, anche sotto vere e proprie rotazioni nello spazio dei colori, le trasformazioni del gruppo SU(3) di colore, analoghe alle rotazioni spaziali dell’esempio. L’introduzione del colore deve essere accompagnata da una considerevole restrizione degli stati ammissibili. Se così non fosse, il pione positivo, una particella composta da un Quark “up” e un Antiquark “down”, dovrebbe essere presente in nove repliche, corrispondenti alle nove possibili scelte per il colore del Quark e dell’Antiquark. Si postulò quindi che solo gli stati invarianti sotto le rotazioni del colore siano possibili. Utilizzando questa restrizione si arriva a giustificare l’esistenza di tutti gli Adroni, le particelle soggette a interazioni forti, effettivamente osservati, senza introdurne altri. In particolare, questa restrizione vieta l’esistenza di Quark liberi che, sebbene attivamente cercati, non sono mai stati rivelati. Inizialmente, i fisici erano incerti se considerare i Quark come vere e proprie particelle o se considerarli invece come un artificio matematico. Successivi sviluppi hanno convinto i fisici, senza ombra di dubbio, che i Quark sono particelle esattamente come lo sono gli elettroni. Sappiamo inoltre che, a distanze inferiori al Fermi (10 alla meno 15ma potenza in metri), le interazioni forti si indeboliscono, e i Quark si comportano come se fossero liberi. Come se all’interno del Protone incontrassimo l’Universo primordiale poco dopo il Big Bang. Un’osservazione che conferma brillantemente l’esistenza dei Quark e del colore è la misura di R, il rapporto tra la probabilità di produzione di Adroni e la probabilità di produzione di Muoni in esperimenti di collisione di elettroni e positroni ad alte energie. I Muoni sono particelle in tutto simili agli elettroni, che differiscono da questi solo perché più pesanti, cioè dotati di una massa circa 200 volte maggiore di quella degli elettroni. Per quanto riguarda la produzione nelle collisioni elettrone-positrone, essi differiscono dai Quark solo nel fatto che questi ultimi hanno carica elettrica frazionaria e portano il colore. Se non fosse per il colore, il valore di R dovrebbe essere uguale alla somma dei quadrati delle cariche elettriche del Quark. L’esistenza delle tre repliche di colore porta a un ulteriore fattore 3 nel valore di R, ma porta anche a una correzione dovuta alle interazioni forti che agiscono tra i Quark. Ma la meccanica quantistica insegna che lo stato di una particella elementare è caratterizzato da un’onda, con una lunghezza d’onda tanto più piccola quanto più alta è la sua energia. Per energie molto al di sopra del GeV (109 ElettronVolt), la lunghezza d’onda delle particelle è molto più piccola di un Fermi. Quindi le interazioni forti si indeboliscono e la “correzione forte” svanisce. Ne segue che, nel limite delle alte energie, il valore di R è proprio dato da tre volte la somma dei quadrati delle cariche dei Quark prodotti. Oggi i fisici hanno una teoria completa delle interazioni forti, nota come Cromodinamica Quantistica (QCD), con le interazioni forti determinate dalle cariche di colore, come le interazioni elettromagnetiche sono determinate dalle cariche elettriche. La neutralità in colore corrisponde all’invarianza di un sistema sotto rotazioni di colore. Si può dimostrare che l’intensità dell’interazione forte descritta dalla QCD diminuisce a piccole distanze e aumenta a grandi distanze. Perciò, è possibile separare a grandi distanze solo particelle prive di carica di colore. La piccola intensità delle interazioni della QCD a piccole distanze (quindi ad alte energie) rende la teoria particolarmente trattabile in questi regimi, per cui i fisici sono in grado di calcolare con precisione diversi processi ad alte energie, come, ad esempio, quelli che hanno luogo nelle collisioni tra protoni in Lhc. I calcoli della QCD sono stati essenziali per la progettazione degli esperimenti di Lhc e sono oggi quotidianamente utilizzati nell’analisi dei dati. Tutto questo mentre circa 2400 studenti delle scuole superiori di tutta Italia possono conoscere dal vivo come funzionano le ricerche dei fisici dal Cern, grazie all’iniziativa Masterclass, coordinata dall’Istituto Nazionale di Fisica Nucleare. Anche quest’anno il progetto ha ottenuto il finanziamento del Ministero dell’Istruzione, dell’Università e della Ricerca (MIUR), essendosi classificato come secondo. I ragazzi si recano nelle università italiane dove vengono accompagnati dai ricercatori in un viaggio nelle proprietà delle particelle, esplorando i segreti del Large Hadron Collider. Ogni università organizza una giornata di lezioni e seminari sugli argomenti fondamentali della fisica delle particelle, seguite da esercitazioni al computer su uno degli esperimenti dell’acceleratore di particelle Lhc (ATLAS, CMS, ALICE o LHCb) dove nel tunnel di 27 Km, a 100 metri di profondità sotto la campagna di Ginevra, le particelle si scontrano quasi alla velocità della luce. I ragazzi possono usare i veri dati provenienti da Lhc, per simulare negli esercizi l’epocale scoperta dell’Higgs, ma anche quella dei Bosoni “W” e “Z”, che nel 1984 valsero il premio Nobel a Carlo Rubbia, e di alcune particelle dotate di una proprietà di nome “stranezza”. Alla fine della giornata, proprio come in una vera collaborazione internazionale, gli studenti si collegano in una videoconferenza con i coetanei di tutta Europa che hanno svolto gli stessi esercizi in altre università, per discutere insieme i risultati emersi dalle esercitazioni. L’iniziativa, giunta all’XI edizione, fa parte delle Masterclass internazionali organizzate da IPPOG (International Particle Physics Outreach Group), che si svolgono contemporaneamente in 42 diverse Nazioni, coinvolgendo 210 tra i più prestigiosi enti di ricerca e università degli Stati Uniti d’Europa, degli Stati Uniti d’America, del Cile, dell’Ecuador, della Giamaica e del Messico e più di 10mila studenti delle scuole superiori. Per l’Istituto Nazionale di Fisica Nucleare sono presenti i Laboratori Nazionali di Frascati e le sezioni di Bologna, Cagliari, Catania, Cosenza, Ferrara, Firenze, Genova, Lecce, Milano, Milano-Bicocca, Napoli, Padova, Pavia, Perugia, Pisa, Roma “La Sapienza”, Roma Tor Vergata, Roma Tre, Torino, Trieste e Udine. La meccanica quantistica può essere fotografata! È la prima immagine della luce come non si era mai vista prima. Un team di ricercatori del Politecnico di Losanna, guidato dall’italiano Fabrizio Carbone, ha realizzato una rappresentazione della luce che mostra in un colpo solo le sue due vere nature, quella ondulatoria di radiazione elettromagnetica e quella corpuscolare fotonica. La natura della luce è stata un rompicapo per secoli. Il partito di chi pensava che fosse fatta di particelle, capeggiato inizialmente da Isaac Newton, come gli Illuminati ha lottato duramente contro la fazione secondo cui la luce era costituita da onde. Quando, nell’Ottocento, James C. Maxwell dimostrò matematicamente che la luce è un’onda elettromagnetica, per il primo gruppo fu una sconfitta eclatante. Ma nel 1905 il giovane Albert Einstein rimescolò le carte, dimostrando che l’effetto fotoelettrico si può spiegare solamente ipotizzando che la luce sia composta da corpuscoli. Fu l’atto di nascita ufficiale della Meccanica quantistica, una teoria che descrive gli enti fondamentali della Natura, tra cui la luce, sia come onde sia come particelle. Niels Bohr, uno dei padri della teoria, coniò addirittura il cosiddetto Principio di complementarità, avvertendo Einstein che Dio può permettersi di tutto, anche di giocare a dati: ogni fenomeno quantistico ha un aspetto corpuscolare e un aspetto ondulatorio, ma non si possono manifestare entrambi contemporaneamente. La luce non fa eccezione. A seconda dell’esperimento con cui la si studia, si rivela come fascio di fotoni o come onda elettromagnetica, ma non si manifesta mai come l’una e l’altra cosa simultaneamente. Finora, forse. Il gruppo svizzero ha infatti pubblicato su Nature Communications l’articolo “Simultaneous observation of the quantization and the interference pattern of a plasmonic near-field” di L. Piazza, T.T.A. Lummen, E Quiñonez, Y. Murooka, B.W. Reed, B. Barwick e F. Carbone, rilasciato in “open access”, fruibile da chiunque senza restrizioni, in cui per la prima volta è possibile osservare la luce comportarsi sia come onda sia come particella. Quando pizzichiamo la corda di una chitarra, l’impulso si propaga lungo la corda, rimbalza agli estremi e si riflette avanti e indietro finché è l’intera corda che vibra. L’onda non si muove più nello spazio e oscilla soltanto nel tempo. È quella che si chiama un’onda stazionaria. Il team elvetico ha creato un’onda stazionaria facendo riflettere un fascio di luce laser all’interno di un nanocavo, una sorta di filo di materiale metallico con uno spessore di appena 80 milionesimi di millimetro. In questo modo la luce, interferendo con se stessa, dà la prova più genuina della sua natura ondulatoria. I ricercatori hanno poi diretto un flusso di elettroni molto vicino al nanocavo. Gli elettroni e i fotoni amano interagire tra loro, e lo fanno scambiandosi dei pacchetti di energia, tutti uguali, che i fisici chiamano quanti: sono il segno inequivocabile della natura corpuscolare della luce. Con un potentissimo microscopio elettronico, Carbone e colleghi hanno poi osservato questi pacchetti. Questo è il punto più sottile e strano da capire: i quanti di energia sono prodotti da un’onda stazionaria, quindi osservare l’onda stazionaria e anche i quanti significa sperimentare contemporaneamente le due nature della luce. “Questo esperimento – rivela Carbone – dimostra che, per la prima volta, siamo in grado di filmare la Meccanica quantistica, e la sua natura paradossale, direttamente. Si tratta di un progresso nel controllo dei fenomeni quantistici alle scale nanoscopiche che potrebbe risultare molto utile, per esempio, nel calcolo quantistico”. Saper padroneggiare in maniera fine la natura quantistica della luce e della materia, è un messaggio molto potente. Porta l’Umanità sempre più vicina a usare queste proprietà, assurde e bizzarre ma del tutto reali, per realizzare computer quantistici in grado di soppiantare senza mezzi termini le nostre tecnologie di calcolo attuali e le emissioni di gas serra in atmosfera. Fare qualcosa che prima sembrava impossibile, apre sempre nuove strade come in Star Trek. E in questo caso, sembra proprio queste strade porteranno molto lontano. L’immagine rappresenta la luce studiata dal gruppo di ricerca del Politecnico di Losanna. L’andamento sinusoidale crescente indica la stazionarietà della radiazione, a prova della sua natura ondulatoria; le gibbosità evidenti su scala più piccola sono i quanti di energia scambiati tra gli elettroni e i fotoni, e dimostrano la natura corpuscolare di questi ultimi. Nell’immagine, quindi, è possibile osservare contemporaneamente la vera natura della luce. Non è una vera e propria istantanea della luce, ma una sorta di grafico quantistico: infatti, i due assi orizzontali rappresentano altrettante dimensioni spaziali, mentre l’asse vertical, ovvero l’altitudine, indica l’energia misurata nell’Anno Internazionale della Luce! Gli Stati Membri del Cern sono: Austria, Belgio, Bulgaria, Repubblica Ceca, Danimarca, Finlandia, Francia, Germania, Grecia, Ungheria, Israele, Italia, Olanda, Norvegia, Polonia, Portogallo, Slovacchia, Spagna, Svezia, Svizzera e Regno Unito. La Romania è candidate per l’ingresso. La Serbia è stato membro associato. India, Giappone, Federazione Russa, Usa, Turchia, Unione Europea, JINR e UNESCO ricoprono le funzioni di Observer Status. La Scienza al servizio della Pace.