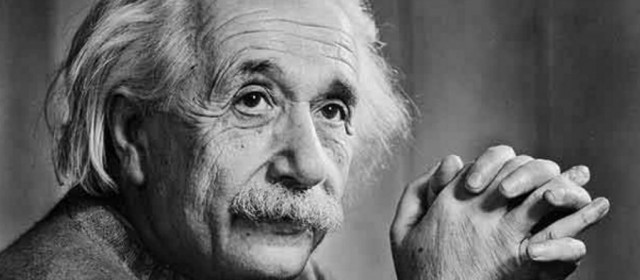

“Non posso credere che Dio giochi a dadi! Non basta essere pacifisti, bisogna essere pacifisti militanti. L’unica razza che conosco è quella umana” (Albert Einstein). Tempus fugit. Il passato, il presente e il futuro non sono predeterminati, sono delle variabili, come insegna da 30 anni Doc Brown, il buon vecchio scienziato di “Back to the future”. Il Continuum spaziotemporale può essere “ingannato” dal viaggiatore del tempo. Se Madre Natura protegge il regolare flusso degli eventi intrappolando il viaggiatore in universi paralleli (10 alla 500ma potenza, secondo Stephen Hawking, dunque maggiori delle nove linee temporali del film!) che possono essere percorsi in tutte le “direzioni” possibili e immaginabili, davvero è sempre garantito il ritorno a casa? Allora, Marty McFly è solo un giovane temponauta fortunato? I Fotoni viaggiano nello spazio e nel tempo. Questo è certo. I Quanti di luce sono le particelle più diffuse nell’Universo. Essi attraversano tutta la Creazione in lungo e in largo a velocità costante (300mila Km/sec) ma impiegano pochissimo tempo per farlo! Per essi infatti il tempo, così come lo concepiamo sulla Terra a basse velocità, sembra quasi non esistere! È in effetti un eterno “presente” spalmato come il miele su una fetta biscottata multistrato. Sembra uno scherzo. Ma l’interazione istantanea delle particelle nel Cosmo è un fatto molto serio in fisica quantistica. Il 18 Aprile del 1955, qualche mese prima dell’esperimento temporale di Doc a base di 1.21 GigaWatt, il grande fisico Albert Einstein lascia la Terra. Lo scienziato che, per riconoscimento unanime, raggiunge le massime vette della conoscenza scientifica universale, offre all’Umanità la possibilità del volo interstellare e del viaggio nel tempo , avendo elaborato del Mondo, dell’Universo e del suo modo di esistere una visione generale e unitaria che traduce, per la prima volta, la continuità tra Spazio e Tempo, tra Materia e Energia (Continuum). Einstein offre di questa continuità una dimostrazione razionale che, come tale, sarebbe stata confermata anche dall’esperienza, senza tuttavia poter superare la contraddizione con la teoria corpuscolare discontinua che pressoché parallelamente si era affermata nel mondo della Fisica. Un dualismo che Einstein suo malgrado accetta perché quella teoria ha tutti i numeri per essere verificata. Suo è il potere mentale di superare la ricerca di una unità nella lettura e nella interpretazione della Natura. È il lavoro di Einstein dopo l’elaborazione nel 1905 della Teoria della Relatività Speciale con la scoperta del Fotone (su cui “viaggia” fin dall’età di 16 anni!) e poi nel 1915 della Teoria della Relatività Generale. Esattamente 100 anni fa, nel Novembre 1915, in quattro lezioni all’Accademia delle Scienze, Albert Einstein presenta la sua Teoria della Relatività Generale, il frutto di dieci anni di studi, in cui il celebre scienziato cerca di raccordare la Relatività (scoperta da Galileo Galilei) Speciale con la Teoria della Gravitazione Universale di Newton che ci è servita per conquistare la Luna e inviare sonde interplanetarie. La formula alla base della nuova teoria, chiamata Equazione di Campo di Einstein, dipinta su t-shirt, magliette, muri, libri e locomotive, si basa sul Principio di Equivalenza, un esempio particolare di Simmetria locale. La proporzionalità tra massa gravitazionale e massa inerziale, infatti, fa sì che per gli osservatori all’interno di una cabina in caduta libera la forza gravitazionale sia, come per “magia”, cancellata! In effetti gli sfortunati occupanti sperimentano per pochi istanti, prima della loro tragica fine, l’assenza di peso degli astronauti sulla Stazione Spaziale Internazionale. Tuttavia, ciò non è vero in assoluto, se si tiene conto del fatto che il campo gravitazionale non è uniforme: infatti, l’enunciato completo del Principio di Equivalenza fa riferimento a corpi di piccola estensione, tali che effetti legati ai gradienti gravitazionali interni ed esterni ad essi possano essere trascurati. La località di questo principio è una conseguenza della dipendenza dalla distanza dal campo gravitazionale. Nel diagramma spazio-temporale di un corpo che si muove in assenza di forze e cade in un campo gravitazionale uniforme, si deduce immediatamente che in assenza di forze il corpo traccia linee rette nello spaziotempo, mentre la Gravità curva queste linee. Ciò spinge Einstein a rappresentare l’interazione gravitazionale attraverso le caratteristiche geometriche delle linee dello spaziotempo descritte dai corpi, che non costituiscono più un reticolato rigido di rette, ma sono un insieme di linee che si curvano in funzione della distribuzione della materia o dell’energia. Per farlo Einstein usa i Fotoni dal cui punto di vista l’Universo non sembra esattamente come ci appare. La grandezza che permette di calcolare la distanza tra punti in uno spaziotempo curvo e, quindi, esprime in termini matematici le proprietà geometriche dello spaziotempo, è il Tensore metrico, una matrice di 4 per 4 componenti. Ciascun termine della matrice si può indicare con “gμν”, dove gli indici “μ” e “ν” vanno da 1 a 4 e rappresentano le coordinate dello spaziotempo. I termini gμν, in un sistema di riferimento qualsiasi, possono assumere valori diversi da punto a punto: ciò è la conseguenza del Principio di Località su cui si fonda l’equazione della Relatività Generale. A sinistra del segno di uguaglianza, oltre a gμν, compare “Rμν”, una matrice che rappresenta la curvatura dello spaziotempo e che dipende dalle derivate seconde del Tensore metrico gμν. A destra, l’altra matrice “Tμν” rappresenta la sorgente dell’interazione gravitazionale che per Einstein non è soltanto la densità della materia, ma anche la densità e il flusso dell’impulso e dell’energia della materia stessa, ovvero il suo stato di moto. Tμν rappresenta quindi il Tensore energia-impulso della meccanica relativistica. Il coefficiente che moltiplica la matrice sorgente rivela quanto sia debole l’effetto della Gravità sulla geometria dello spaziotempo flessibile: una significativa curvatura dello spaziotempo si ottiene quando entrano in gioco forze che compensano il piccolissimo fattore “G/c4”. In senso figurato, si usa dire che la materia e il suo stato di moto (Tμν) determinano la struttura locale delle linee dello spaziotempo (Rμν e gμν) che a loro volta determinano lo stato di moto della materia. In termini matematici, la formula rappresenta un sistema di equazioni accoppiate non lineari, la cui soluzione in genere è ricavabile solo per via numerica. La Gravitazione di Einstein descrive fenomeni non previsti dalla teoria di Newton e in particolare apre il nuovo capitolo della Gravitodinamica: partendo da questa equazione, il 22 Giugno 1916 Albert Einstein presenta all’Accademia prussiana come si trasforma questa equazione nell’ipotesi di una piccola perturbazione di uno spaziotempo in cui la Gravità sia assente. Ricava così la ben più nota equazione delle onde di D’Alembert, che rappresenta la propagazione della perturbazione. È la prima e completa teorizzazione dell’esistenza di onde gravitazionali, vere e proprie perturbazioni dello spaziotempo, in attesa di essere confermate sperimentalmente. Tuttavia, occorre attendere i lavori di Bondi e Pirani della fine degli Anni Cinquanta per avere un’analisi rigorosa dell’effetto prodotto da un’onda su masse liberamente gravitanti. Si dimostra così che questo effetto è osservabile. È su queste basi che Jo Weber raccoglie la sfida di costruire il primo rivelatore di onde gravitazionali. Edoardo Amaldi dà impulso alla ricerca sui rivelatori di onde gravitazionali in Italia, che poi si è sviluppata nell’Infn, esplorando diverse strategie di misura che hanno portato alla realizzazione dell’attuale interferometro Virgo. Nella sua configurazione iniziale, pur non rivelando nessun segnale gravitazionale, Virgo ha già ottenuto significativi risultati scientifici, ponendo limiti a una vasta categoria di modelli cosmologici basati sulla Teoria delle Stringhe e deducendo i limiti superiori di deformazione dalla forma sferica di alcune stelle Pulsar. Come dire, un limite sull’altezza di improbabili “montagne” eventualmente presenti su stelle di neutroni! Ma la sfida sperimentale per la prima rivelazione, continua con Advanced Virgo (Adv). Il nuovo interferometro è progettato per ottenere una sensibilità di circa un ordine di grandezza superiore a quella di Virgo, con un aumento di circa tre ordini di grandezza del tasso di segnali gravitazionali emessi nella fase finale della vita di un sistema di due stelle di neutroni che, spiraleggiando l’una attorno all’altra, finiscono per collidere liberando un’enorme quantità di energia gravitazionale. Esso è uno dei tre rivelatori della rete internazionale di cui sono parte integrante i due analoghi interferometri del progetto Ligo negli Stati Uniti d’America con il famoso fisico del colossal “Interstellar”, Kip Thorne. Advanced Virgo è ora nella fase di integrazione dei suoi componenti fondamentali, realizzati nei laboratori dell’Infn, del Cnrs e di Nikhef. Adv ha una configurazione ottica diversa da Virgo e dei nuovi specchi. Per ridurre l’impatto del rumore termico e le fluttuazioni della pressione di radiazione, la massa degli specchi è ora di 42 kg rispetto ai 22 kg di Virgo ed è stata aumentata la dimensione del fascio laser che vi incide. Pertanto, a differenza di Virgo, la sezione più stretta del flusso fotonico nelle cavità principali sarà posizionata vicino al centro delle cavità Fabry-Perot di 3 km di lunghezza. Specchi più pesanti e fasci luminosi che investono una porzione più vasta della loro superficie hanno richiesto un grande sforzo tecnologico che ha portato allo sviluppo di nuove macchine di deposizione di film sottili, sospensioni degli specchi più performanti, connessioni da vuoto più grandi nella zona centrale e nuovi telescopi ottici all’ingresso e all’uscita dell’interferometro, il cui allineamento è un’ulteriore sfida sperimentale per gli scienziati. La fase di integrazione è ormai prossima alla conclusion. La rete dei rivelatori Ligo-Advanced Virgo sarà completata nel 2016 con l’obiettivo dichiarato di rivelare il primo segnale di onde gravitazionali prima della fine di questo decennio e dare così un’ulteriore conferma sperimentale della Relatività Generale di Einstein. Il Mondo è fatto di noi stessi e dell’ambiente in cui viviamo, vicino e lontano, visibile e invisibile, creato da Dio come preghiamo nel Credo. Nell’ambiente ci sono oggetti e fenomeni che si svolgono nello spazio e nel tempo, offrendocene la percezione con un certo “ritardo” nei segnali ottico-elettrici interpretati dal cervello. Tutto questo sembra evolvere seguendo regole precise che sin dall’antichità chiamiamo Leggi di Natura benché, con la Meccanica Quantistica, anche il puro “caso” sembra essere entrato nel novero dei motori del cambiamento, delle vere “riforme”, accanto ai rapporti di causa-effetto che oggi sembrano “giustificare” la perversa azione dei Warlords sulla Terra. La descrizione degli eventi richiede una tecnica di registrazione che, come requisito generale minimo, ha bisogno di un sistema di riferimento spaziale, in tre dimensioni, più un insieme di orologi disseminati in tutto lo spazio e sincronizzati, e altri strumenti di misura. È diffuso l’uso di adottare, per lo spazio, una terna di assi cartesiani realizzati con l’incrocio di superfici piane rigide ortogonali, anche se questa non è la sola possibilità. Per il tempo, la misura si basava in passato sulla regolare scansione di fenomeni astronomici periodici, mentre oggi fa riferimento a oscillazioni atomiche e, tra breve, sulle pulsazioni stellari. Ci sono poi strumenti che misurano la massa, l’elasticità dei corpi, la fluidità dei liquidi, le forze (spinte, attrazioni), le frequenze e altre quantità. Il che richiede l’adozione di un vasto sistema convenzionale di unità di misura per ciascun tipo di grandezza misurata. Le Leggi di Natura sono espresse matematicamente da relazioni tra grandezze fisiche del tipo A uguale a B oppure A maggiore di B. Un’importante disuguaglianza è il Principio di Indeterminazione di Heisenberg, vero protagonista del celebre universo di “Star Trek The Next Generation” di Gene Roddenberry. A e B sono combinazioni o funzioni di altre grandezze e, nel caso delle leggi di evoluzione, contengono delle derivate, cioè delle variazioni temporali e spaziali. Un carattere universalmente valido che si applica a tutte le leggi è il Principio di Omogeneità: A e B devono avere le stesse unità di misura, il che significa che il loro rapporto deve essere un numero puro. Questo principio, lungi dall’essere una banale astrazione, porta in certi casi a risultati concreti attraverso ragionamenti di scala che rappresentano una generalizzazione della nozione geometrica di similitudine. Il prototipo di tutte le leggi matematiche della Natura è la Legge della Gravitazione Universale di Newton. Essa afferma che la Forza di Gravità tra due corpi è proporzionale alle masse “m” e “m1” dei corpi e inversamente proporzionale al quadrato della loro distanza. In notazione moderna, la scriviamo come: F=Gmm1/r², dove G è la costante di Newton. Combinata con l’equazione fondamentale della dinamica F=ma (Forza=massa per accelerazione), la legge newtoniana della Gravità permette di calcolare con grande precisione i moti planetari e per secoli è stata alla base della meccanica celeste e, quindi, del volo spaziale interplanetario. Solo nel 1915 è stata soppiantata dalla Legge della Gravitazione di Einstein che la incorpora come caso limite valido quando il campo gravitazionale è debole e non modifica sensibilmente lo spaziotempo. Affinché il primo e il secondo membro dell’equazione della Gravità di Newton siano espressi entrambi nelle unità di misura della forza, in base al principio di omogeneità, è necessario che la costante G non sia un numero puro, ma abbia anch’essa delle opportune unità di misura. Se ponessimo infatti G uguale a 1, analogamente a quel che si fa in Relatività dove si pone la velocità della luce nel vuoto “c” uguale a 1, caratterizzando le lunghezze in tempi-luce, dovremmo misurare le masse in metri e secondi, anziché in chilogrammi! Fino all’inizio del XIX Secolo si riteneva che tutti i fenomeni fisici fossero riconducibili al moto di corpi materiali soggetti ad azioni a distanza, come la forza di Gravità e altre modellate su questa. Le entità fondamentali erano quindi particelle, ossia oggetti localizzati la cui posizione spaziale è specificata da tre coordinate cartesiane funzioni del tempo: x(t), y(t), z(t). Le equazioni della dinamica permettevano, una volta risolte, di determinare queste leggi temporali. Nel corso dell’Ottocento emerse un’altra importantissima nozione, quella di Campo, di cui siamo debitori soprattutto al grande James Clerk Maxwell. L’Elettromagnetismo è una Fisica di Campi, cioè di entità diffuse nello spazio, rappresentate da funzioni del tipo A(x,y,z,t) che dipendono dalle coordinate spaziali e dal tempo. I campi sono retti anch’essi da equazioni di evoluzione che ne permettono di prevedere la configurazione in un qualunque istante futuro, una volta che sia nota la sua configurazione nell’istante iniziale. Sebbene siano tutte riconducibili a uguaglianze o disuguaglianze tra grandezze, del tipo A=B e A>B, le Leggi della Natura sono molto diverse tra loro, sia per la matematica che coinvolgono sia per il loro status fisico. Esistono leggi universali e leggi di applicabilità limitata, leggi che permettono di predire l’evoluzione nel tempo dei sistemi e leggi che descrivono il Mondo così com’è in un determinato istante. È impossibile classificare in maniera esauriente tutte le leggi fisiche che magari un giorno saranno rappresentate da un singolo semplice simbolo. L’equazione di Newton “F=ma” combinata con la legge di gravitazione universale, le equazioni di Maxwell, l’equazione di Dirac e l’equazione della Relatività Generale, sono esempi di leggi di evoluzione, leggi di grande generalità che governano un vasto numero di fenomeni. Da un punto di vista matematico, si tratta di equazioni differenziali in cui compaiono le variazioni istantanee (le derivate) di funzioni che descrivono lo stato di un sistema: posizione e velocità delle particelle in meccanica classica, i campi nell’elettromagnetismo, la funzione d’onda in meccanica quantistica. Per risolvere le equazioni dinamiche bisogna conoscere le condizioni iniziali, cioè lo stato del sistema in un istante iniziale. Queste condizioni sono in genere aleatorie e non soggette ad alcuna regolarità, ma determinano, assieme alle leggi di evoluzione, gli stati successivi del sistema. La relazione tra energia e massa, il Principio di Indeterminazione di Heisenberg, la relazione tra energia e temperatura e l’equazione di Boltzmann, sono esempi di Leggi di stato, perché evidenziano delle connessioni stabili tra diverse proprietà di un sistema. In alcuni casi queste leggi convertono certe grandezze in altre: E=mc² converte masse in energie e viceversa, mentre le leggi della meccanica statistica (E=kT e S=klogW) convertono grandezze macroscopiche (la temperatura T e l’entropia S) in grandezze microscopiche (energia delle particelle E e numero di stati microscopici W). A differenza che nelle società democratiche, nella Fisica c’è qualcosa che sta al di sopra delle leggi: sono i Principi di Simmetria che svolgono il ruolo di Super Leggi. Come insegna il fisico teorico Eugene Wigner, “le simmetrie sono leggi che le leggi di natura devono rispettare”. I principi di simmetria stabiliscono che le leggi di evoluzione devono essere invarianti rispetto a certe trasformazioni. Rispetto agli spostamenti spaziali e temporali, rispetto alle rotazioni, rispetto alle trasformazioni di Lorentz, che fanno passare da un sistema di riferimento a un altro (Principio di Relatività) o rispetto ad alcune trasformazioni della funzione d’onda. Come dimostra la matematica tedesca Emmy Noether nel 1918, le simmetrie hanno come necessaria conseguenza le Leggi di Conservazione, un’altra importante classe di leggi fisiche. Queste stabiliscono che nel corso dei fenomeni alcune grandezze (energia, quantità di moto, momento angolare, carica elettrica e così via) non variano. Sono gli strumenti più utili e più comodi del fisico, perché permettono di ottenere informazioni sui processi per mezzo di una matematica elementare. Già le ricerche di Michael Faraday, Georg Ohm, André-Marie Ampère e molti altri, provvedono a rimpolpare la fenomenologia dell’elettromagnetismo, ma è Maxwell a scrivere le equazioni definitive del campo elettrico e del campo magnetico che hanno spalancato le porte all’Elettronica. In particolare, egli capì che l’aggiunta di un termine correttivo, la cosiddetta Corrente di Spostamento consistente nella variazione temporale del campo elettrico, alla legge di Ampère, garantisce la conservazione della carica elettrica e genera l’equazione delle onde. Il “miracolo” delle equazioni di Maxwell sta nel fatto che esse contengono i presupposti della Relatività di Albert Einstein. Perché, a differenza delle equazioni della meccanica newtoniana, godono della simmetria relativistica, cioè sono invarianti rispetto alle trasformazioni di Lorentz dei sistemi di riferimento. Ciò può essere reso evidente introducendo un oggetto matematico chiamato Tensore, una generalizzazione dei vettori ordinari, che incorpora il campo elettrico e il campo magnetico. Scritte in termini di tensori, le equazioni di Maxwell assumono una forma particolarmente compatta e soprattutto simmetrica a colpo d’occhio. Dopo la fisica newtoniana dei corpuscoli e delle forze a distanza, e la fisica maxwelliana dei campi, nella seconda metà del Novecento si realizza la grande sintesi: le particelle e le forze sono entrambe descritte da Campi Quantizzati. Nasce l’Elettrodinamica Quantistica (Qed), la teoria degli Elettroni e dei Fotoni, le cui implicazioni tecnologiche pacifiche (volo interstellare) sono per lo più ancora sconosciute. Uno dei protagonisti di questa svolta è il fisico Richard Feynman, il quale pubblica nel 1948 un lavoro che produrrà una sorta di insospettabile riconciliazione tra il vecchio e il nuovo: una riformulazione della Teoria Quantistica diversa da quella di Werner Heisenberg e da quella di Erwin Schrödinger, e basata su un principio della meccanica classica, il Principio di Minima Azione. Questo stabilisce che la traiettoria di un corpo è quella che rende minima una quantità chiamata Azione che possiamo immaginare come il prodotto dell’energia del corpo per la durata del moto. Nella meccanica classica, il principio di minima azione permette di derivare l’equazione del moto di un corpo, una volta che siano note le sue interazioni. Feynman mostra che in meccanica quantistica la probabilità che una particella si propaghi da un punto a un altro dello spaziotempo si può calcolare sommando tutti i possibili cammini (storie) della particella tra i due punti, con un opportuno peso per ogni cammino, dipendente dall’azione. Questo approccio, applicato alla Teoria Quantistica dei Campi, conduce a una specie di Fisica a fumetti, ovvero a una rappresentazione dei processi elementari e delle loro equazioni mediante figure chiamate “diagrammi di Feynman” che interpretano tali processi ordinandoli secondo un numero crescente di Mediatori dell’interazione. Nel caso della elettrodinamica quantistica, i Fotoni, cioè le particelle di luce scoperte da Einstein. In un diagramma si rappresenta l’urto di due elettroni con scambio di un fotone e di due fotoni. Si tratta in entrambi i casi di fotoni virtuali, cioè di fotoni che vivono per un brevissimo intervallo di tempo. Un’altro mostra invece il diagramma dell’annichilazione Elettrone-Positrone in cui si produce un fotone virtuale che si materializza poi in altre coppie di particelle cariche. Ancora un Elettrone e un Positrone, oppure un Muone positivo e un Muone negativo, o altre particelle più pesanti, a seconda dell’energia disponibile. L’intensità dell’interazione elettromagnetica è espressa da una costante di struttura fine, chiamata Alfa (α). Ogni diagramma di Feynman corrisponde a un’equazione proporzionale a una potenza di α, il cui esponente è dato dalla metà del numero di punti di interazione contenuti nel diagramma: così i due diagrammi sono, rispettivamente, di ordine α e di ordine α2. Per calcolare esattamente un processo reale, bisognerebbe sommare un numero infinito di diagrammi. Fortunatamente la piccolezza di α che è un numero inferiore a 0,01 fa sì che i pochi diagrammi degli ordini più bassi diano già un’ottima approssimazione. L’elettrodinamica quantistica è attualmente la teoria fisica più precisa. Le sue predizioni si accordano con i dati sperimentali fino alla nona cifra significativa, cioè con un errore inferiore a una parte su un miliardo. Per conseguire questi successi, la Teoria Quantistica dei Campi ha dovuto annientare un nemico: l’infinito numerico. Appena si considerano diagrammi che descrivono un dato processo oltre l’ordine più basso in α, infatti, le equazioni danno valori infiniti. Il problema, in un certo senso, era presente già in fisica classica: l’energia potenziale dovuta al campo elettrico generato da un elettrone cresce man mano che ci si avvicina alla sorgente e diventa infinita nel punto in cui si trova l’elettrone stesso che è una particella puntiforme ma anche un’onda. Nell’ambito della Teoria Quantistica dei Campi, il problema è che il Vuoto Quantistico non è vuoto, ma pullula di Fotoni e di cariche prodotte in coppie, complessivamente neutre, di Elettroni e Positroni, virtuali, effimeri, che vengono prodotti e riassorbiti dall’Elettrone originario e producono guai alla teoria. Ma un complesso sistema di trucchi nella cosiddetta “rinormalizzazione”, basata sulla ridefinizione dei Campi e dei parametri della teoria, sempre ideata da Feynman assieme a Julian Schwinger e Sin-Itiro Tomonaga negli Anni ’40 del XX Secolo, permette di cancellare gli infiniti. L’esito finale è quella straordinaria capacità predittiva dell’Elettrodinamica Quantistica che rende possibile l’impossibile come Alice nel Paese delle Meraviglie. Negli Anni ’70, gli olandesi Gerardus ‘t Hooft e Martinus Veltman hanno dimostrato che la rinormalizzazione funziona anche con le teorie che descrivono le altre Forze fondamentali del mondo subnucleare, quelle che compongono il Modello Standard. La storia delle leggi e delle equazioni, e dello sforzo dei fisici per calcolare il Mondo, ha raggiunto così il suo temporaneo successo. Ci saranno sicuramente altri capitoli, ma per il momento sono ancora bozze. Nel libro di Pietro Greco su Albert Einstein, si offre un’avvincente ricostruzione della vicenda personale dello scienziato Einstein non solo ripercorrendo una storia durata svariati decenni, ma anche attraverso una preziosa introduzione in cui si legge di quella mania del ricercatore moderno, che inizia da Galilei e Newton. Cioè da quando la Scienza perde la sua natura metafisica in cambio dell’assunzione di valori razionali come la dimostrazione, la verifica, la coerenza, conservando, tuttavia, nel caso di Einstein, quella concezione derivante dalla seduzione ionica, cioè dalla metafisica dell’intima unità della Natura. Una “fede” che ovviamente non può essere accettata dal nostro scienziato per il quale è necessaria una concezione e una dimostrazione scientifica. La mancata unificazione tra la teoria del continuo e quella corpuscolare, il “marmo pregiato e il legno scadente” come ironicamente le definisce Einstein, non è tuttavia un errore attribuibile all’una o all’altra, ma semplicemente indica la necessità di superare, nel caso della teoria corpuscolare, il punto cui era arrivata, che non può essere considerato come conclusivo. Il lavoro dei fisici avrebbe dovuto essere questo anche in Italia dove Enrico Fermi avrebbe potuto costruire la sua prima Pila nucleare. La probabilità che dopo il 1905 proprio Einstein potesse essere il fisico pregiudicato per un tale successo, dipendeva anche dal fatto che il “giovane fisico pensa e agisce al di fuori di ogni costrizione di pensiero. Non ha vincoli accademici. Non ha problemi di carriera. Non ha maestri né piste di ricerca prestabilite. Può pensare alla grande. Può sciogliere come crede le briglie della sua creatività e della sua visione del mondo”, come ricorda l’Autore. Un’attività, quella della ricerca scientifica, che si regge non sul nepotismo ma nel rispetto rigoroso di alcuni princìpi ovvi: la razionalità, la coerenza, la dimostrazione, senza i quali non solo non ci sarebbe sviluppo della conoscenza, ma nemmeno la ricerca stessa della conoscenza. E quindi la prosperità e la libertà. Tuttavia tutte quelle altre condizioni di cui, come osserva Greco, Einstein gode, giocano, non solo nel caso di Einstein, una parte rilevante nella creazione e intuizione di ipotesi interpretative tali da costituire dei passaggi storici nella costruzione della nostra conoscenza. Questo bagaglio complessivo ha una dimensione etica che si riflette nella qualità della società e della vita di tutti. Questa qualità etica non è una deviazione ma un necessario arricchimento senza il quale una personalità come quella di Einstein perde una componente essenziale. Non sono solo le nuove scoperte della fisica che ci dicono che Einstein aveva ragione. In qualche modo anche la Storia e la Politica ci portano alla stessa constatazione, ancora oggi sulla Terra che sembra quasi impazzita a causa dei Signori della Guerra che non sono scienziati. Albert Einstein non è stato solo un genio della fisica, il più grande in assoluto. È stato anche un ispiratore della Politica e della Vita sulla Terra. Non di quella politicante che, ahinoi, ben conosciamo in Italia, in Europa e nel Mondo ormai rassegnato al caos delle guerre permanenti, ma di quella alta, visionaria, ordinata dei grandi personaggi che hanno forgiato il XX Secolo, da Roosevelt a Gandhi, da Russel a Nehru, da JFK a Putin in pieno Obamismo! Dunque, “Einstein aveva ragione. Mezzo secolo di impegno per la pace” (ScienzaExpress, 2012), è un libro per tutti. Sì, la Pace, prima di tutto. Nato in Germania, a Ulma, il 14 Marzo 1879 e morto a Princeton (NJ, Usa) il 18 Aprile 1955, l’ebreo non praticante Albert Einstein compie un percorso a suo modo esemplare attraverso due guerre mondiali, la rivoluzione dei Soviet, l’Olocausto del Popolo Ebraico per mano nazifascista, la sconfitta di Hitler grazie alla Russia, la nascita dello Stato di Israele, le due bombe nucleari (non “atomiche”!) americane sulle citta nipponiche di Hiroshima e Nagasaki (che inaugurano la Guerra Fredda), lo Stalinismo, il Maccartismo, l’Equilibrio Nucleare del Terrore e la nascita dell’Unione Europea. Formidabili sì quegli anni, vissuti da Einstein da protagonista sia per aver scosso dalle fondamenta l’edificio della fisica newtoniana con la messa a punto in due riprese della Relatività, Speciale nel 1905 e Generale nel 1915, con la prima conferma sperimentale nel 1919 per via astronomica, sia per aver dato un contributo determinante alla nascita delle Politiche di Pace moderne tra Usa e Urss, abbandonando le pericolose teorie settecentesche. L’inutile insensata carneficina della Prima Guerra Mondiale fa maturare in Albert Einstein, prima impiegato all’Ufficio brevetti di Berna, poi docente in diverse università in Svizzera e in Germania, una volontà di pace istintiva, via via sempre più radicale. Al punto da spingere il già noto professore di fisica a prendere posizione, in piena guerra, per l’obiezione di coscienza totale. “Non basta essere pacifisti – sostiene Einstein – bisogna essere pacifisti militanti”. Il suo ragionamento era che se una moltitudine di giovani si fosse rifiutata di arruolarsi nell’esercito, lo Stato avrebbe avuto difficoltà a punirli tutti con il carcere o il plotone di esecuzione, e lo spirito bellico si sarebbe dileguato. Esemplare lezione evidentemente poco conosciuta alle Nazioni Unite e ad alcuni analisti geopolitici. Ancora oggi. Ingenuo e geniale allo stesso tempo, fin dalle prime riflessioni, in Einstein la pace è un valore non negoziabile, come apprende nelle sue letture giovanili di Kant, in particolare del suo scritto sulla “Pace perpetua”, oltre che della “Critica della ragion pura” che legge a 13 anni. Einstein è convinto che per difendere la pace serve l’unione di tante volontà. L’esempio individuale non basta. Ecco allora la necessità che le politiche di pace escano dalla sfera della coscienza individuale per farsi movimento politico. La Prima Guerra Mondiale termina con la disfatta e l’umiliazione a Versailles della Germania costretta a cedere Alsazia e Lorena e a pagare straordinari debiti di guerra in oro. Matura pericolosamente in quegli anni lo spirito di vendetta e il cieco nazionalismo che troverà un maligno interprete nel caporale austriaco Adolf Hitler. Ma prima dell’avvento del nazismo nel 1933, la Germania conosce le favole del socialismo, la vertiginosa libertà intellettuale della Repubblica di Weimar, l’illusione spartachista di Rosa Luxemburg rapita e assassinata nel 1919 insieme al sodale Karl Liebknecht. In questa temperie, Einstein si fa portavoce mondiale di pace, solidarietà e democrazia che lo metteno al riparo dal fascino esercitato dalla cosiddetta “democrazia popolare” dei Soviet, rendendolo inviso sia ai regimi comunisti sia a quelli liberali che in fondo furono responsabili dei due disastri bellici europei e della Rivoluzione di Lenin in Russia contro lo Zar Nicola II e la Famiglia Imperiale dei Romanov oggi canonizzati dalla Chiesa Ortodossa. Verso la fine degli Anni ‘20 l’Europa, messa in ginocchio dalla crisi economica, è percorsa dal veleno dell’antisemitismo nazista, che spinge Einstein e tanti altri scienziati europei (come Enrico Fermi, subito dopo il Premio Nobel per la Fisica nel 1938) a lasciare la Germania per la Svizzera e in seguito, a partire dal 1933, per Princeton negli Stati Uniti d’America, dove resterà fino alla morte. La Seconda Guerra Mondiale (1939-1945) muta le condizioni di contorno inducendo Einstein a cambiare atteggiamento verso una opzione pacifista e non-violenta, predicata da Gandhi in quegli anni di resistenza al dominio della Corona britannica in India. Viene infatti giudicata inadatta a fronteggiare le “forze del Male” che sempre più chiaramente si delineano in Europa e che egli coglie da subito, senza i tentennamenti, quando non i tradimenti, di molti altri intellettuali, primo fra tutti il “nazificato” Martin Heidegger. Per quanto i campi di sterminio tedeschi siano ancora di là da venire dopo quelli stalinisti, la persecuzione degli Ebrei è già una realtà in Germania, che genera come antidoto il movimento sionista e un nuovo esodo verso la Palestina. Einstein aderisce al movimento, ma a modo suo, accettando la necessità di una terra d’asilo ma rifiutando la costituzione di un nuovo Stato. Albert resta, in cuor suo, un uomo di libertà, allergico a ogni nazionalismo, politicamente corretto e statolatria. Come insegna Kant, “la pace si potrà pure installare sulla Terra a patto che i popoli superino le chiusure nazionaliste federandosi sotto un unico ordine mondiale a cui rimandare almeno l’uso legittimo della forza”. È oggi il pensiero del Presidente russo Vladimir Putin pronunciato all’Onu per il 70.mo anniversario di fondazione, limitatamente all’Alleanza contro il Male che imperversa sulla Terra. Ma all’epoca le armate del Fuhrer dilagano in Europa, rendendo sempre più insostenibile il credo pacifista. Einstein, per usare l’espressione di Greco, si “autosospende” da pacifista militante. Anche perché proprio in quegli anni dal cilindro della fisica esce l’idea della bomba nucleare. Prima Otto Hahn e Lise Meitner, poi Enrico Fermi, osservano il fenomeno della fissione nucleare: l’Uranio, opportunamente bombardato da Neutroni, si spezza, decadendo in Bario, un atomo di massa notevolmente più piccola. Dov’è finita la massa mancante? Sarà Lise Meitner a suggerire che la chiave sta proprio nella celebre formula di Einstein, E=mc². Il resto della Massa si trasforma in Energia. In un solo grammo di Uranio che subisce teoricamente una fissione totale, l’energia è pari alla combustione di 3 tonnellate di carbone. Ma l’efficienza delle prime bombe americane sarà nettamente inferiore, grazie a Dio! L’amico Leo Slizard è fra i primi a comprendere le conseguenze di quella scoperta peraltro temuta dal fisico italiano Ettore Majorana: in pochi anni si potrebbe produrre una bomba capace di distruggere un’intera città. I suoi inviti a non divulgare i particolari delle sperimentazioni, che si moltiplicano a cavallo fra il 1939 e il 1940 tra Francia, Stati Uniti d’America e Germania, restano inascoltati. E il guaio è che il Terzo Reich ha gli scienziati (come Heisenberg) e i laboratori adatti per arrivare prima degli altri a confezionare questo inusitato strumento di morte, attraverso la produzione di Acqua Pesante, il Deuterio. Einstein coglie al volo l’entità della nuova minaccia, sospende il suo impegno pacifista e si decide a scrivere la famosa lettera indirizzata al Presidente degli Stati Uniti Franklin Delano Roosevelt. È il 2 Agosto 1939. “Signor Presidente – scrive Einstein – alcune ricerche svolte recentemente da E. Fermi e L. Szilard, mi inducono a ritenere che l’uranio possa essere trasformato nell’immediato futuro in una nuova e importante fonte di energia. Negli ultimi quattro mesi è stata confermata la probabilità (grazie all’opera di Joliot in Francia, oltre che di Fermi e Szilard in America) che diventi possibile avviare in una grande massa di uranio una reazione nucleare a catena capace di generare enormi quantità di energia e grandi quantitativi di nuovi elementi simili al radio. Attualmente è quasi certo che si possa pervenire a questo risultato nell’immediato futuro. Questo nuovo fenomeno porterebbe anche alle costruzione di bombe, ed è concepibile (anche se molto meno certo) che si possano costruire in tal modo bombe estremamente potenti di tipo nuovo. Una sola bomba di questo tipo, trasportata da un’imbarcazione e fatta esplodere in un porto, potrebbe benissimo distruggere l’intero porto e una parte del territorio circostante. Può darsi tuttavia che tali bombe si rivelino troppo pesanti per essere trasportabili per via aerea. Gli Stati Uniti dispongono soltanto di moderati quantitativi di minerale uranifero molto povero. Si trova minerale buono in Canada e nell’ex-Cecoslovacchia, mentre la più importante fonte di uranio è il Congo Belga. Potrà appariLe opportuno istituire un collegamento permanente tra l’Amministrazione e il gruppo di fisici che si occupano di reattori a catena in America. Uno dei modi di assicurare tale collegamento potrebbe consistere nell’affidare questo compito a persona che goda della Sua fiducia, e che potrebbe eventualmente agire in veste non ufficiale. Il suo compito potrebbe consistere in quanto segue: a) prendere contatto con i dicasteri governativi mantenendoli informati sugli ulteriori sviluppi, e formulare raccomandazioni per interventi governativi, con particolare riguardo al problema di assicurare agli Stati Uniti un approvvigionamento di minerale uranifero; b) accelerare il lavoro sperimentale che si svolge attualmente nei limiti dei bilanci dei laboratori universitari, fornendo finanziamenti – ove necessario – tramite contatti con privati disposti a contribuire a questa causa, e anche eventualmente procurando la cooperazione di laboratori industriali che dispongano dell’attrezzatura necessaria. Mi risulta che la Germania ha effettivamente bloccato la vendita di uranio da parte delle miniere cecoslovacche di cui si è impadronita. La decisione di agire così tempestivamente si può forse spiegare con la circostanza che il figlio del Sottosegretario di Stato tedesco, von Weizsàcker, lavora al Kaiser-Wilhelm-Institut di Berlino, dove vengono attualmente compiute, in parte, le stesse ricerche sull’uranio che si svolgono negli Stati Uniti. Sinceramente Suo, Albert Einstein”. La lettera di Einstein invita il Presidente alla massima vigilanza. Ma ci vorranno ancora tre anni con l’attacco giapponese a Pearl Harbour il 7 Dicembre 1941 e la conseguente entrata in guerra degli Stati Uniti d’America, nonché la dimostrazione della reazione a catena da parte di Enrico Fermi, realizzata in uno scantinato a Chicago il 2 Dicembre 1942, perché maturino le condizioni scientifiche e politiche per l’avvio del Progetto Manhattan diretto da Robert Oppenheimer. Il resto è storia ancora ben impressa nella coscienza mondiale sempre più abituata alle guerre permanenti: il 16 Luglio 1945 viene fatta esplodere la prima bomba nucleare al Plutonio ad Alamogordo, simile a quella che annienterà parzialmente Nagasaki, il 9 Agosto 1945, benché il Terzo Reich fosse già caduto nell’operazione a tenaglia delle truppe americane e sovietiche. Tre giorni dopo la prima bomba nucleare fatta eplodere su Hiroshima. Inizia la Guerra Fredda. Ma gli scienziati non demordono e non si dividono. Anzi. Condividono sempre tutte le loro scoperte, animati dallo spirito di Einstein, nonostante le pressioni ideologiche dei due blocchi. Lo spettro di una probabile Apocalisse Nucleare era ormai uscito dal Vaso di Pandora. Rimettercelo diventa la missione degli ultimi dieci anni di Albert Einstein sulla Terra. Il fisico, ormai vera e propria icona pop della cultura e del costume al pari di Gandhi e Charlie Chaplin, più volte finito in copertina su Time e intervistato dai media di mezzo mondo, chiude il periodo di autosospensione per forgiare un pacifismo del tutto nuovo, all’altezza delle nuove sfide che si trova a fronteggiare. Il mondo gioca con la possibilità reale, che si affaccia per la prima volta nella storia grazie anche allo sviluppo tecnico-scientifico, della sua completa autodistruzione assicurata. Sull’orlo del baratro, Einstein si chiede, e ci chiede oggi, che direzione vogliamo prendere. Il bivio è chiaro, almeno nella sua mente: da una parte la proliferazione nucleare governata da politici, militari, industria e scienziati acquiescenti, teso a instaurare l’Equilibrio del Terrore che guarda caso oggi viene alimentato dal Terrorismo Globale a colpi di decapitazioni; dall’altra il disarmo e il libero esercizio della Scienza finalizzato all’innovazione, alla prosperità e alla pace sulla Terra e altrove. Inutile dire che, almeno fino a quando domina la contrapposizione fra Usa e Urss, è la prima via ad avere la meglio. Quanto peggiore e pericoloso sarebbe stato lo scenario mondiale senza la testimonianza di Einstein! Senza di lui, senza Bertrand Russel e tanti altri scienziati che firmarono il famoso “Appello per la pace e il disarmo”, a pochi giorni dalla sua morte nel 1955, forse il Movimento per il disarmo nucleare (come il Pugwash) non avrebbe avuto la stessa forza. L’Agenzia atomica internazionale non avrebbe forse varato negli stessi termini il programma “Atom for peace”. E la Scienza avrebbe sicuramente subito fatica a salvaguardare la propria autonomia dai programmi di secretazione della ricerca sul nucleo parte dei militari. Firmano il Manifesto scienziati e intellettuali di prestigio: Albert Einstein, Bertrand Russell, Max Born (Premio Nobel per la fisica), Percy W. Bridgman (Premio Nobel per la fisica), Leopold Infeld (Professore di fisica teorica), Frédéric Joliot-Curie (Premio Nobel per la chimica), Herman J. Muller (Premio Nobel per la fisiologia e medicina), Linus Pauling (Premio Nobel per la chimica), Cecil F. Powell (Premio Nobel per la fisica), Józef Rotblat (Professore di fisica) e Hideki Yukawa (Premio Nobel per la fisica). “Nella tragica situazione che l’umanità si trova ad affrontare – si legge nell’importante Dichiarazione in favore del disarmo nucleare e della scelta pacifista per l’umanità – riteniamo che gli scienziati debbano riunirsi per valutare i pericoli sorti come conseguenza dello sviluppo delle armi di distruzione di massa e per discutere una risoluzione nello spirito del documento che segue. Non parliamo, in questa occasione, come appartenenti a questa o a quella nazione, continente o credo, bensì come esseri umani, membri del genere umano, la cui stessa sopravvivenza è ora in pericolo. Il mondo è pieno di conflitti, e su tutti i conflitti domina la titanica lotta tra comunismo e anticomunismo. Chiunque sia dotato di una coscienza politica avrà maturato una posizione a riguardo. Tuttavia noi vi chiediamo, se vi riesce, di mettere da parte le vostre opinioni e di ragionare semplicemente in quanto membri di una specie biologica la cui evoluzione è stata sorprendente e la cui scomparsa nessuno di noi può desiderare. Tenteremo di non utilizzare parole che facciano appello soltanto a una categoria di persone e non ad altre. Gli uomini sono tutti in pericolo, e solo se tale pericolo viene compreso vi è speranza che, tutti insieme, lo si possa scongiurare. Dobbiamo imparare a pensare in modo nuovo. Dobbiamo imparare a domandarci non già quali misure adottare affinché il gruppo che preferiamo possa conseguire una vittoria militare, poiché tali misure ormai non sono più contemplabili; la domanda che dobbiamo porci è: “Quali misure occorre adottare per impedire un conflitto armato il cui esito sarebbe catastrofico per tutti?”. La gente comune, così come molti uomini al potere, ancora non ha ben compreso quali potrebbero essere le conseguenze di una guerra combattuta con armi nucleari. Si ragiona ancora in termini di città distrutte. Si sa, per esempio, che le nuove bombe sono più potenti delle precedenti e che se una bomba nucleare è riuscita a distruggere Hiroshima, una bomba all’idrogeno potrebbe distruggere grandi città come Londra, New York e Mosca. È fuor di dubbio che in una guerra con bombe all’idrogeno verrebbero distrutte grandi città. Ma questa non sarebbe che una delle tante catastrofi che ci troveremmo a fronteggiare, e nemmeno la peggiore. Se le popolazioni di Londra, New York e Mosca venissero sterminate, nel giro di alcuni secoli il mondo potrebbe comunque riuscire a riprendersi dal colpo. Tuttavia ora sappiamo, soprattutto dopo l’esperimento di Bikini, che le bombe nucleari possono portare gradatamente alla distruzione di zone molto più vaste di quanto si fosse creduto. Fonti autorevoli hanno dichiarato che oggi è possibile costruire una bomba 2500 volte più potente di quella che distrusse Hiroshima. Se fatta esplodere a terra o in mare, tale bomba disperde nell’atmosfera particelle radioattive che poi ridiscendono gradualmente sulla superficie sotto forma di pioggia o pulviscolo letale. È stato questo pulviscolo a contaminare i pescatori giapponesi e il loro pescato. Nessuno sa con esattezza quanto si possono diffondere le particelle radioattive, ma tutti gli esperti sono concordi nell’affermare che una guerra con bombe all’idrogeno avrebbe un’alta probabilità di portare alla distruzione della razza umana. Si teme che l’impiego di molte bombe all’idrogeno possa portare alla morte universale – morte che sarebbe immediata solo per una minoranza, mentre alla maggior parte degli uomini toccherebbe una lenta agonia dovuta a malattie e disfacimento. In più occasioni eminenti uomini di scienza ed esperti di strategia militare hanno lanciato l’allarme. Nessuno di loro afferma che il peggio avverrà per certo. Ciò che dicono è che il peggio può accadere e che nessuno può escluderlo. Non ci risulta, per ora, che le opinioni degli esperti in questo campo dipendano in alcuna misura dal loro orientamento politico e dai loro preconcetti. Dipendono, a quanto emerso dalle nostre ricerche, dalla misura delle loro competenze. E abbiamo riscontrato che i più esperti sono anche i più pessimisti. Questo dunque è il problema che vi poniamo, un problema grave, terrificante, da cui non si può sfuggire: metteremo fine al genere umano, o l’umanità saprà rinunciare alla guerra? È una scelta con la quale la gente non vuole confrontarsi, poiché abolire la guerra è oltremodo difficile. Abolire la guerra richiede sgradite limitazioni alla sovranità nazionale. Ma forse ciò che maggiormente ci impedisce di comprendere pienamente la situazione è che la parola “umanità” suona vaga e astratta. Gli individui faticano a immaginare che a essere in pericolo sono loro stessi, i loro figli e nipoti e non solo una generica umanità. Faticano a comprendere che per essi stessi e per i loro cari esiste il pericolo immediato di una mortale agonia. E così credono che le guerre potranno continuare a esserci, a patto che vengano vietate le armi moderne. Ma non è che un’illusione. Gli accordi conclusi in tempo di pace di non utilizzare bombe all’idrogeno non verrebbero più considerati vincolanti in tempo di guerra. Con lo scoppio di un conflitto armato entrambe le parti si metterebbero a fabbricare bombe all’idrogeno, poiché se una parte costruisse bombe e l’altra no, la parte che ha fabbricato le bombe risulterebbe inevitabilmente vittoriosa. Tuttavia, anche se un accordo alla rinuncia all’armamento nucleare nel quadro di una generale riduzione degli armamenti non costituirebbe la soluzione definitiva del problema, avrebbe nondimeno una sua utilità. In primo luogo, ogni accordo tra Oriente e Occidente è comunque positivo poiché contribuisce a diminuire la tensione internazionale. In secondo luogo, l’abolizione delle armi termonucleari, nel momento in cui ciascuna parte fosse convinta della buona fede dell’altra, diminuirebbe il timore di un attacco improvviso come quello di Pearl Harbour, timore che al momento genera in entrambe le parti uno stato di agitazione. Dunque un tale accordo andrebbe accolto con sollievo, quanto meno come un primo passo. La maggior parte di noi non è neutrale, ma in quanto esseri umani dobbiamo tenere ben presente che affinché i contrasti tra Oriente e Occidente si risolvano in modo da dare una qualche soddisfazione a tutte le parti in causa, comunisti e anticomunisti, asiatici, europei e americani, bianchi e neri, tali contrasti non devono essere risolti mediante una guerra. È questo che vorremmo far capire, tanto all’Oriente quanto all’Occidente. Ci attende, se lo vogliamo, un futuro di continuo progresso in termini di felicità, conoscenza e saggezza. Vogliamo invece scegliere la morte solo perché non siamo capaci di dimenticare le nostre contese? Ci appelliamo, in quanto esseri umani, ad altri esseri umani: ricordate la vostra umanità, e dimenticate il resto. Se ci riuscirete, si aprirà la strada verso un nuovo Paradiso; altrimenti, vi troverete davanti al rischio di un’estinzione totale. Invitiamo questo congresso, e per suo tramite gli scienziati di tutto il mondo e la gente comune, a sottoscrivere la seguente mozione: In considerazione del fatto che in una futura guerra mondiale verrebbero certamente impiegate armi nucleari e che tali armi sono una minaccia alla sopravvivenza del genere umano, ci appelliamo con forza a tutti i governi del mondo affinché prendano atto e riconoscano pubblicamente che i loro obbiettivi non possono essere perseguiti mediante una guerra mondiale e di conseguenza li invitiamo a trovare mezzi pacifici per la risoluzione di tutte le loro controversie”. Per alcuni anni subito dopo la Seconda Guerra Mondiale l’immagine di Einstein risente della paternità della bomba nucleare che qualcuno vuole accordargli. Cosa storicamente non vera, giacché il fisico di Princeton non vuole partecipare al Progetto Manhattan e si limita a schierarsi con gli Alleati negli anni del grande scontro con l’Asse nazifascista. Ma su di Einstein quell’ombra rimane indelebile e lo porta ad accollarsi la sua parte di responsabilità per l’innocenza perduta della Scienza. Lo strenuo impegno per la pace e l’utopia di un Governo Mondiale che togliesse ai singoli Stati l’uso legittimo della forza, è il suo modo di riscattare più che se stesso una intera comunità di scienziati. Il libro di Greco narra tutto questo non tralasciando aneddoti gustosi, quelli sull’infanzia di Einstein e sui problematici matrimoni, e approfondimenti di aspetti meno noti al pubblico, come la farsa della fisica nazista che si scaglia violentemente contro la teoria ebraica della relatività. O come l’invito del governo ebraico a diventare Presidente dello Stato di Israele dopo la morte di Chaim Weizmann, che Einstein declina con un certo imbarazzo. O come lo straordinario sviluppo del movimento pacifista internazionale e dei “fisici atomici per la pace”, che ancora oggi è alle prese con il rallentamento del disarmo dopo le speranze accese da Gorbaciov, da Reagan, dalla caduta del Muro di Berlino e dalla fine dell’Urss. Einstein aveva pienamente ragione e il libro mostra molto bene quanto poco gli si attagliasse il cliché del fisico perso nei suoi pensieri e distaccato dal mondo. Paul Adrien Maurice Dirac è senza dubbio uno fra i massimi fisici di tutti i tempi. Dal 1926 al 1928, in tre articoli, getta le basi della Meccanica Quantistica, della Teoria Quantistica dei Campi e, con l’equazione che porta il suo nome, della moderna teoria delle particelle elementari (Modello Standard). La famosa Equazione di Dirac per l’Elettrone appare nel 1928. È difficile non provare ammirazione di fronte alla bellezza di una tale equazione: conciliando la Meccanica Quantistica e la Relatività di Einstein, introduce un nuovo formalismo a quattro componenti (gli Spinori) che va al di là del concetto di Tensore. Permettendo di descrivere il moto dell’Elettrone libero, ma anche di entità composite libere come Protoni e Neutroni, prevede un moto di “rotazione” intrinseco dell’Elettrone, il cosiddetto spin, con valori quantizzati seminteri (l’elicità dell’elettrone, ossia la componente dello spin lungo la direzione di moto, può prendere solo due valori, +1/2 ovvero -1/2), associato a un momento magnetico, che permette di spiegare alcuni aspetti misteriosi degli spettri atomici. Ma pone anche un problema nuovo, quello delle energie negative. Infatti, se si risolve l’equazione di Dirac per un singolo Elettrone, si ottengono due soluzioni, una positiva e una negativa, allo stesso modo per cui la radice quadrata di 49 è +7 e -7. La soluzione negativa era preoccupante: l’energia negativa, che era in sé un’idea imbarazzante, implicava, per la famosa equazione della Relatività Speciale di Einstein, E=mc², una massa negativa: una cosa chiaramente assurda! All’epoca, ovviamente nessuno aveva mai visto questi oggetti con energia negativa. Si racconta che un teorico li chiamò “elettroni asini” che “se li tiri in avanti, si muovono all’indietro”! Forse, il Tempo e l’Anti-Tempo? Capita spesso nell’ambito della ricerca scientifica che la soluzione di un problema ne faccia emergere uno nuovo, completamente inaspettato, la cui soluzione rappresenta un progresso significativo della conoscenza. Capita così anche a Dirac che lotta con le energie negative per l’intero 1929, finché non giunge alla conclusione che esse non possono essere evitate. La spiegazione che offre è che gli stati a energia negativa non si vedono, perché occupano lo stato di minima energia possibile che è lo stato di vuoto. Gli Elettroni a energia positiva non possono cadere in questo mare senza fondo, perché non vi è spazio per loro. Però può succedere, così come ogni tanto un pesce salta fuori dall’acqua, che un Elettrone presente in questo mare, investito da un fascio di luce, possa saltar fuori, acquistando un’energia positiva e lasciando una buca nella posizione originaria. Questa buca apparirebbe come una sorta di elettrone “opposto”: stessa massa, ma con carica positiva corrispondente a un’assenza di carica negativa ed energia positiva. È così che l’equazione di Dirac predice un nuovo tipo di materia: l’Antimateria, del tutto simile alla materia ma con carica opposta. Per un bel po’ di tempo, però, Dirac fu riluttante ad accettare la predizione dell’esistenza di un Anti-Elettrone, a tal punto da identificarlo con il Protone! Qualche anno più tardi l’Antielettrone, chiamato Positrone, viene scoperto da Carl D. Anderson nei raggi cosmici. Scoperta che gli valse il premio Nobel per la fisica del 1936. È un vero trionfo per l’Equazione di Dirac. “L’equazione – afferma lo scienziato in seguito – era stata più intelligente di me”. Ma il trionfo sperimentale ancora maggiore è la produzione di Anti-Protoni da parte di Emilio Segré e Owen Chamberlain nel 1956, la produzione di Antideutoni da parte di Antonino Zichichi e altri nel 1965, per arrivare alla produzione dell’Anti-Idrogeno al Cern di Ginevra alla fine del secolo scorso. Oggigiorno i Positroni vengono prodotti e utilizzati quotidianamente sia in ambito scientifico sia medicale (nella Pet, la Positron Emission Tomography). L’Equazione di Dirac ha inoltre un’altra conseguenza ancora più sorprendente, destinata a cambiare radicalmente il modo di concepire la materia: le particelle elementari non sono enti immutabili come secondo la filosofia di Democrito, ma possono trasformarsi tra loro, così come un Fotone, un quanto di luce, che interagisse con la materia può trasformarsi in una coppia Elettrone-Positrone. Le loro caratteristiche, come la carica e la massa, sono determinate dalla presenza del vuoto quantistico con il quale esse interagiscono. Un’altra predizione dell’Equazione di Dirac è il valore pari a due per il fattore giromagnetico “g” dell’Elettrone o di qualsiasi altra particella elementare di spin pari a 1/2. Si tratta del rapporto opportunamente “normalizzato” tra il momento magnetico e quello angolare di spin. Classicamente, un corpo carico rotante intorno a un asse di simmetria produce un momento di dipolo magnetico (come una spira percorsa da corrente) e un momento angolare. Si può dimostrare che in questo caso g=1, uguaglianza che rimane valida anche nella Meccanica Quantistica. Nel 1925 Samuel Goudsmit e George Eugene Uhlenbeck mostrano come l’introduzione di un campo magnetico associato allo spin dell’Elettrone possa spiegare gli spettri atomici osservati nel Litio e nel Sodio, se si assume per “g” il valore empirico g=2. Questo valore ha la sua naturale giustificazione solo nel 1928, come predizione dell’Equazione di Dirac. Devono passare circa altri 20 anni prima che misure sperimentali, condotte da John Nafe, Edward Nelson e Isidor Rabi sulla struttura iperfine dell’Idrogeno e del Deuterio, e da Polykarp Kusch e Henry Foley su atomi di Gallio, mostrino nel 1947 che “g” invece differisce da 2 per circa lo 0,1%, ossia che esiste un contributo “extra” anomalo al momento magnetico dell’Elettrone, espresso dall’anomalia del momento magnetico (a) nella semplice formula a=(g−2)/2. Cosa provoca questo contributo anomalo al momento magnetico dell’Elettrone? Non possono che essere le correzioni radiative, il ribollire del “vuoto”, quel vuoto quantistico pieno di particelle virtuali (le particelle fantasma, presenti ma invisibili, che sono un carattere centrale della Teoria Quantistica dei Campi) a permettere all’Elettrone di emettere e assorbire un Fotone virtuale. Detto in altre parole, i demoni di Dirac che si agitano nello stato di vuoto avevano degli effetti tangibili e misurabili! Non è Dirac o la prima generazione di fisici che fondarono la Meccanica Quantistica, a calcolare gli effetti delle fluttuazioni del vuoto quantistico, ma una nuova generazione di fisici tra cui Julian Schwinger, enfant prodige della fisica teorica del Dopoguerra, che all’età di quattordici anni ha modo di assistere a una conferenza di Dirac sulla teoria delle buche. Nel 1948 egli calcola il contributo anomalo al momento magnetico dell’Elettrone trovando un ottimo accordo con il valore sperimentale di Kusch e Foley. Per la misura del momento magnetico anomalo dell’Elettrone, Kusch riceve il premio Nobel nel 1955 e Schwinger, assieme a Richard Feynman e Sin- Itiro Tomonaga, nel 1965 per lo sviluppo dell’Elettrodinamica Quantistica. La storia delle misure del momento magnetico dell’Elettrone e poi, successivamente, del Muone è uno dei capitoli più belli della fisica sperimentale. Esperimenti di precisione sempre maggiore hanno messo in evidenza come all’anomalia dell’Elettrone e del Muone, che data la massa 200 volte superiore a quella dell’Elettrone, ha una sensibilità maggiore alle fluttuazioni del vuoto quantistico e ai possibili contributi di Nuova Fisica, contribuiscano non solo le coppie di Elettroni e Positroni, ma anche i Quark e i portatori delle interazioni forti e anche i Bosoni W+, W–, Z°, messaggeri delle interazioni deboli. Anche il Bosone di Higgs dà il suo contributo all’anomalia del Muone. All’inizio degli Anni 2000, misurando il momento magnetico anomalo del Muone a una precisione di 540 parti per miliardo, che equivale a conoscere il fattore giromagnetico “g”, paragonato al diametro della Terra, con un’incertezza pari alle dimensioni di una formica, i fisici del Brookhaven National Laboratory di Upton, nello Stato di New York, hanno trovato che il valore misurato si discosta da quello teorico di tre deviazioni standard e la probabilità che questo accada a causa di una fluttuazione statistica è dello 0,3%. Questa discrepanza, per quanto non conclusiva, potrebbe essere spiegata dal contributo all’anomalia del Muone di particelle tuttora ignote, come le Particelle Supersimmetriche che si cercano ora nel supercollisore Lhc, o dei Nuovi Fotoni, particelle di spin pari a 1, con una massa diversa da zero, che potrebbero spiegare la Materia Oscura. Decisivi per le future astronavi interstellari a propulsione fotonica! Per poter capire se si tratta di una crepa nel Modello Standard o di una fluttuazione statistica o di un eventuale effetto strumentale, è in fase di costruzione al Fermilab di Chicago (Usa) un nuovo esperimento (Muon g-2) che misurerà l’anomalia del Muone con una precisione di 140 parti per miliardo. Anche grazie al risultato di questo esperimento, a cui partecipa per l’Italia anche l’Infn, tra qualche anno sapremo se il Modello Standard debba essere abbandonato a favore di una teoria più completa. Come tutti gli esseri umani, anche gli scienziati e i ricercatori discutono tra loro, a volte litigano, per difendere le proprie teorie e i propri risultati. Forse in pochi conoscono la storia del duello tra scienziati, forse il più importante e famoso. Comincia nell’Anno Domini 1927. Ventidue anni prima, nel suo annus mirabilis, Albert Einstein aveva rivoluzionato la fisica, introducendo idee davvero incredibili, come il fatto che lo spazio e il tempo possano accorciarsi o allungarsi, o che la luce viaggi in pacchetti di quanti ben definiti chiamati Fotoni. Le scoperte di Einstein e di altri portano alla nascita di un nuovo tipo di fisica, detta Quantistica, che presto dimostra la sua solidità spiegando molti fenomeni sino allora incomprensibili. In soli 22 anni però la Fisica Quantistica arriva a conclusioni così stupefacenti da essere difficili da digerire anche per lo stesso Einstein che pure aveva contribuito alla sua nascita. Secondo il Principio di Indeterminazione, colonna portante della Fisica Quantistica, ogni oggetto è sia una particella sia un’onda, e non è possibile determinarne la posizione e la velocità allo stesso tempo. Una conseguenza di ciò è che non si possono misurare certe cose oltre una data precisione, e particelle come Elettroni o Fotoni vanno considerate non come oggetti con una precisa posizione nello spazio, ma come semplici Distribuzioni di Probabilità. Einstein si mostra sin dall’inizio scettico su queste conclusioni: è sicuro che ci sia qualcos’altro sotto, una teoria ulteriore che permetta di misurare tutto con assoluta precisione. Con queste idee, nell’Ottobre 1927 si reca al Congresso Solvay a Bruxelles. Per dare un’idea del livello della Conferenza, basti dire che tra i 27 partecipanti si possono incontrare 17 premi Nobel o futuri premi Nobel. Tra i partecipanti, oltre ad Einstein, figurano Schrodinger, Pauli, Heisenberg, Brillouin, Bragg, Dirac, de Broglie, Langmuir, Planck, Marie Curie, Langevin oltre a Niels Bohr, il fisico danese che aveva descritto per primo la struttura dell’atomo. E proprio tra Einstein e Bohr comincia una discussione di vari giorni sulla validità del Principio di Indeterminazione. Come spesso accade in questi casi, le discussioni più importanti non avvengono durante i seminari ufficiali, ma a tavola o al bar, mentre si mangia! Allo stesso modo è nata la Teoria Olografica che ha messo a dura prova le idee di Hawking. Ogni mattina a colazione Einstein presenta a Bohr un esperimento (sic!) immaginario che sembra contraddire il Principio di Indeterminazione. Bohr lo studia fino a che riesce a controbattere la critica di Einstein, solo per trovare Einstein il giorno dopo pronto con un nuovo diverso esperimento intellettuale immaginario. Uno dei più astuti proposti da Einstein immagina di avere una scatola da cui in un preciso momento esce un raggio di luce. Pesando la scatola prima e dopo e sfruttando la relazione di Einstein che collega la massa all’energia, si può ottenere l’energia del raggio di luce emesso. Conoscendo l’energia del raggio e il momento esatto in cui è uscito, si riuscirebbe a contraddire il Principio di Indeterminazione! È un esperimento davvero ben congegnato. Bohr rimane sconvolto dalla sua apparente perfezione. Un’altro scienziato del Congresso descriverà la scena come “un vero shock per Bohr che all’inizio non riuscì a trovare una soluzione. Estremamente agitato, andò per tutta la sera da uno scienziato all’altro, provando a convincere tutti che non poteva essere, che sarebbe stata la fine della Fisica. Ma non riuscì a trovare nessuna soluzione per risolvere il paradosso. Non dimenticherò mai l’immagine dei due scienziati mentre lasciavano il club: Einstein, alto e autorevole, che camminava tranquillamente con un sorriso ironico e soddisfatto, e Bohr che gli trotterellava dietro, agitatissimo”. Bohr passa probabilmente una notte insonne temendo di aver perso il duello, ma il giorno dopo trova una soluzione sfruttando, paradossalmente, proprio la Teoria della Relatività di Einstein. In particolare, Bohr dimostra che la forza di Gravità necessaria a pesare la scatola influenzerà anche, proprio secondo le teorie di Einstein, lo scorrere del tempo e quindi la misura dell’attimo esatto in cui la particella lascia la scatola! Alla fine, Bohr vince il duello. Einstein continuerà per vari anni a provare a confutare il Principio di Indeterminazione. Non riuscirà mai a convincersi che non sia possibile, per l’Uomo, arrivare alla verità assoluta. I fatti dimostrano, per ora, che Einstein aveva torto. Non dobbiamo immaginare però il dibattito tra Einstein e Bohr come un litigio tra due persone che vogliano avere ragione ad ogni costo, per non ammettere di aver sbagliato. I due si stimano e sono amici, ed ognuno di loro difende strenuamente la propria opinione non per amor proprio, ma per sete di conoscenza. Entrambi vogliono, assolutamente, arrivare alla Verità. Ciò non toglie che, nella foga, essi cercassero con ogni mezzo di confutare le idee dell’altro. La migliore conferma della Teoria di Einstein giunge dai Premi Nobel per la Fisica 2015 conferiti al giapponese Takaaki Kajita e al canadese Arthur B. McDonald, per il loro contributo chiave agli esperimenti che hanno dimostrato l’Oscillazione del Neutrino, studiata anche ai Laboratori Nazionali del Gran Sasso dell’Infn. Questa metamorfosi richiede che i neutrini abbiano massa: la scoperta ha cambiato la nostra comprensione dei meccanismi più intimi della materia e può rivelarsi cruciale non solo per la nostra visione dell’Universo ma anche per la